-

-而在本节中我们会将PyTorch训练好的模型转换为ONNX 格式,然后使用ONNX Runtime运行它进行推理。通过本节课的学习,你将收获:

-

-1. 模型部署的整体流程

-2. 使用torch.onnx进行模型格式的转化

-3. 使用ONNX Runtime进行模型推理

-4. 完整的官方代码解释

-

-## 9.1.1 ONNX和ONNX Runtime简介

-

-### 9.1.1.1 ONNX简介

-

-- ONNX官网:https://onnx.ai/

-- ONNX GitHub:https://github.com/onnx/onnx

-

-**ONNX( Open Neural Network Exchange)** 是 Facebook (现Meta) 和微软在2017年共同发布的,用于标准描述计算图的一种格式。ONNX通过定义一组与环境和平台无关的标准格式,使AI模型可以在不同框架和环境下交互使用,ONNX可以看作深度学习框架和部署端的桥梁,就像编译器的中间语言一样。由于各框架兼容性不一,我们通常只用 ONNX 表示更容易部署的静态图。硬件和软件厂商只需要基于ONNX标准优化模型性能,让所有兼容ONNX标准的框架受益。目前,ONNX主要关注在模型预测方面,使用不同框架训练的模型,转化为ONNX格式后,可以很容易的部署在兼容ONNX的运行环境中。目前,在微软,亚马逊 ,Facebook(现Meta) 和 IBM 等公司和众多开源贡献的共同维护下,ONNX 已经对接了下图的多种深度学习框架和多种推理引擎。

-

-

-

-### 9.1.1.2 ONNX Runtime简介

-

-- ONNX Runtime官网:https://www.onnxruntime.ai/

-- ONNX Runtime GitHub:https://github.com/microsoft/onnxruntime

-

-**ONNX Runtime** 是由微软维护的一个跨平台机器学习推理加速器,它直接对接ONNX,可以直接读取.onnx文件并实现推理,不需要再把 .onnx 格式的文件转换成其他格式的文件。PyTorch借助ONNX Runtime也完成了部署的最后一公里,构建了 PyTorch --> ONNX --> ONNX Runtime 部署流水线,我们只需要将模型转换为 .onnx 文件,并在 ONNX Runtime 上运行模型即可。

-

-### 9.1.1.3 ONNX和ONNX Runtime的安装

-

-ONNX和ONNX Runtime作为python的一个包与其他包的安装方法相同,我们可以选择使用conda或者pip进行安装,只需要输入以下命令即可:

-

-```shell

-# 激活虚拟环境

-conda activate env_name # env_name换成环境名称

-# 安装onnx

-pip install onnx

-# 安装onnx runtime

-pip install onnxruntime # 使用CPU进行推理

-# pip install onnxruntime-gpu # 使用GPU进行推理

-```

-

-除此之外,我们还需要注意ONNX和ONNX Runtime之间的适配关系。我们可以访问ONNX Runtime的Github进行查看,链接地址如下:

-

-ONNX和ONNX Runtime的适配关系:https://github.com/microsoft/onnxruntime/blob/master/docs/Versioning.md

-

-当我们想使用GPU进行推理时,我们需要先将安装的onnxruntime卸载,再安装onnxruntime-gpu,同时我们还需要考虑ONNX Runtime与CUDA之间的适配关系,我们可以参考以下链接进行查看:

-

-ONNX Runtime和CUDA之间的适配关系:https://onnxruntime.ai/docs/execution-providers/CUDA-ExecutionProvider.html

-

-## 9.1.2 模型导出为ONNX

-

-### 9.1.2.1 模型转换为ONNX格式

-

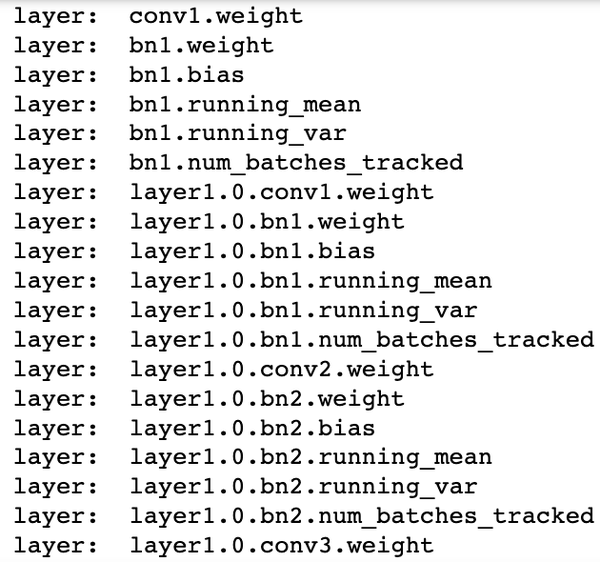

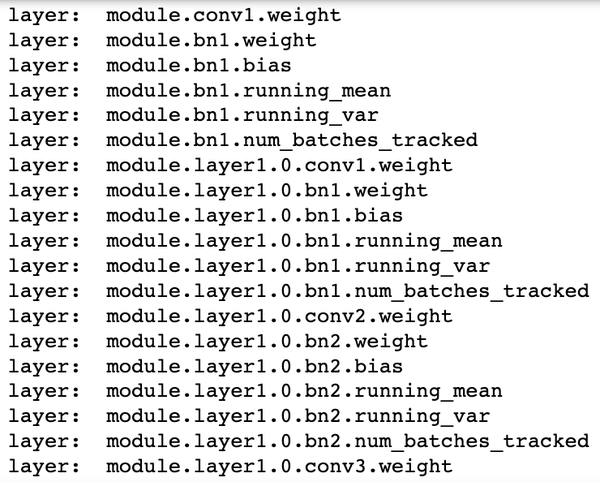

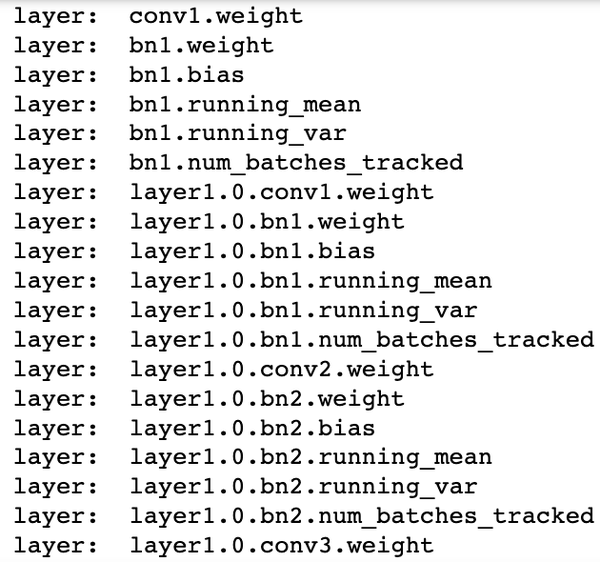

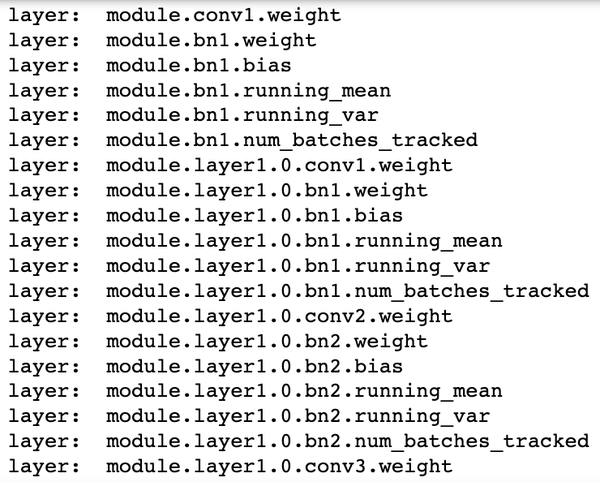

-在接下来的部分,我们将使用`torch.onnx.export()`把模型转换成 ONNX 格式的函数。模型导成onnx格式前,我们必须调用`model.eval()`或者`model.train(False)`以确保我们的模型处在推理模式下,避免因为`dropout`或`batchnorm`等运算符在推理和训练模式下的不同产生错误。(因为本课程偏向实战,对于ONNX的内部流程不做过多赘述,有兴趣的同学可以进行更深一步了解)

-

-```python

-import torch.onnx

-# 转换的onnx格式的名称,文件后缀需为.onnx

-onnx_file_name = "xxxxxx.onnx"

-# 我们需要转换的模型,将torch_model设置为自己的模型

-model = torch_model

-# 加载权重,将model.pth转换为自己的模型权重

-# 如果模型的权重是使用多卡训练出来,我们需要去除权重中多的module. 具体操作可以见5.4节

-model = model.load_state_dict(torch.load("model.pth"))

-# 导出模型前,必须调用model.eval()或者model.train(False)

-model.eval()

-# dummy_input就是一个输入的实例,仅提供输入shape、type等信息

-batch_size = 1 # 随机的取值,当设置dynamic_axes后影响不大

-dummy_input = torch.randn(batch_size, 1, 224, 224, requires_grad=True)

-# 这组输入对应的模型输出

-output = model(dummy_input)

-# 导出模型

-torch.onnx.export(model, # 模型的名称

- dummy_input, # 一组实例化输入

- onnx_file_name, # 文件保存路径/名称

- export_params=True, # 如果指定为True或默认, 参数也会被导出. 如果你要导出一个没训练过的就设为 False.

- opset_version=10, # ONNX 算子集的版本,当前已更新到15

- do_constant_folding=True, # 是否执行常量折叠优化

- input_names = ['input'], # 输入模型的张量的名称

- output_names = ['output'], # 输出模型的张量的名称

- # dynamic_axes将batch_size的维度指定为动态,

- # 后续进行推理的数据可以与导出的dummy_input的batch_size不同

- dynamic_axes={'input' : {0 : 'batch_size'},

- 'output' : {0 : 'batch_size'}})

-

-```

-

-### 9.1.2.2 ONNX模型的检验

-

-当上述代码运行成功后,我们会得到一个ONNX 模型文件。我们需要检测下我们的模型文件是否可用,我们将通过`onnx.checker.check_model()`进行检验,具体方法如下:

-

-```python

-import onnx

-# 我们可以使用异常处理的方法进行检验

-try:

- # 当我们的模型不可用时,将会报出异常

- onnx.checker.check_model(self.onnx_model)

-except onnx.checker.ValidationError as e:

- print("The model is invalid: %s"%e)

-else:

- # 模型可用时,将不会报出异常,并会输出“The model is valid!”

- print("The model is valid!")

-```

-

-### 9.1.2.3 ONNX可视化

-

-在将模型导出为onnx格式后,我们希望有个工具可以像Tensorboard一样可视化模型来观察每个节点的属性特征。随着`Netron`的出现,我们也可以实现onnx的可视化。

-- Netron下载网址:https://github.com/lutzroeder/netron

-

-

-使用Netron进行可视化后,我们不仅能看到整体模型的架构,还能看到每一个节点的信息。在接下来的内容中我们将以Netron官方提供的[squeezenet](https://netron.app/?url=https://media.githubusercontent.com/media/onnx/models/main/vision/classification/squeezenet/model/squeezenet1.0-3.onnx)为例进行介绍。下面第一幅图截取自squeezenet网络,我们可以看到网络的整体流程和输入。

-

-

-

-而在本节中我们会将PyTorch训练好的模型转换为ONNX 格式,然后使用ONNX Runtime运行它进行推理。通过本节课的学习,你将收获:

-

-1. 模型部署的整体流程

-2. 使用torch.onnx进行模型格式的转化

-3. 使用ONNX Runtime进行模型推理

-4. 完整的官方代码解释

-

-## 9.1.1 ONNX和ONNX Runtime简介

-

-### 9.1.1.1 ONNX简介

-

-- ONNX官网:https://onnx.ai/

-- ONNX GitHub:https://github.com/onnx/onnx

-

-**ONNX( Open Neural Network Exchange)** 是 Facebook (现Meta) 和微软在2017年共同发布的,用于标准描述计算图的一种格式。ONNX通过定义一组与环境和平台无关的标准格式,使AI模型可以在不同框架和环境下交互使用,ONNX可以看作深度学习框架和部署端的桥梁,就像编译器的中间语言一样。由于各框架兼容性不一,我们通常只用 ONNX 表示更容易部署的静态图。硬件和软件厂商只需要基于ONNX标准优化模型性能,让所有兼容ONNX标准的框架受益。目前,ONNX主要关注在模型预测方面,使用不同框架训练的模型,转化为ONNX格式后,可以很容易的部署在兼容ONNX的运行环境中。目前,在微软,亚马逊 ,Facebook(现Meta) 和 IBM 等公司和众多开源贡献的共同维护下,ONNX 已经对接了下图的多种深度学习框架和多种推理引擎。

-

-

-

-### 9.1.1.2 ONNX Runtime简介

-

-- ONNX Runtime官网:https://www.onnxruntime.ai/

-- ONNX Runtime GitHub:https://github.com/microsoft/onnxruntime

-

-**ONNX Runtime** 是由微软维护的一个跨平台机器学习推理加速器,它直接对接ONNX,可以直接读取.onnx文件并实现推理,不需要再把 .onnx 格式的文件转换成其他格式的文件。PyTorch借助ONNX Runtime也完成了部署的最后一公里,构建了 PyTorch --> ONNX --> ONNX Runtime 部署流水线,我们只需要将模型转换为 .onnx 文件,并在 ONNX Runtime 上运行模型即可。

-

-### 9.1.1.3 ONNX和ONNX Runtime的安装

-

-ONNX和ONNX Runtime作为python的一个包与其他包的安装方法相同,我们可以选择使用conda或者pip进行安装,只需要输入以下命令即可:

-

-```shell

-# 激活虚拟环境

-conda activate env_name # env_name换成环境名称

-# 安装onnx

-pip install onnx

-# 安装onnx runtime

-pip install onnxruntime # 使用CPU进行推理

-# pip install onnxruntime-gpu # 使用GPU进行推理

-```

-

-除此之外,我们还需要注意ONNX和ONNX Runtime之间的适配关系。我们可以访问ONNX Runtime的Github进行查看,链接地址如下:

-

-ONNX和ONNX Runtime的适配关系:https://github.com/microsoft/onnxruntime/blob/master/docs/Versioning.md

-

-当我们想使用GPU进行推理时,我们需要先将安装的onnxruntime卸载,再安装onnxruntime-gpu,同时我们还需要考虑ONNX Runtime与CUDA之间的适配关系,我们可以参考以下链接进行查看:

-

-ONNX Runtime和CUDA之间的适配关系:https://onnxruntime.ai/docs/execution-providers/CUDA-ExecutionProvider.html

-

-## 9.1.2 模型导出为ONNX

-

-### 9.1.2.1 模型转换为ONNX格式

-

-在接下来的部分,我们将使用`torch.onnx.export()`把模型转换成 ONNX 格式的函数。模型导成onnx格式前,我们必须调用`model.eval()`或者`model.train(False)`以确保我们的模型处在推理模式下,避免因为`dropout`或`batchnorm`等运算符在推理和训练模式下的不同产生错误。(因为本课程偏向实战,对于ONNX的内部流程不做过多赘述,有兴趣的同学可以进行更深一步了解)

-

-```python

-import torch.onnx

-# 转换的onnx格式的名称,文件后缀需为.onnx

-onnx_file_name = "xxxxxx.onnx"

-# 我们需要转换的模型,将torch_model设置为自己的模型

-model = torch_model

-# 加载权重,将model.pth转换为自己的模型权重

-# 如果模型的权重是使用多卡训练出来,我们需要去除权重中多的module. 具体操作可以见5.4节

-model = model.load_state_dict(torch.load("model.pth"))

-# 导出模型前,必须调用model.eval()或者model.train(False)

-model.eval()

-# dummy_input就是一个输入的实例,仅提供输入shape、type等信息

-batch_size = 1 # 随机的取值,当设置dynamic_axes后影响不大

-dummy_input = torch.randn(batch_size, 1, 224, 224, requires_grad=True)

-# 这组输入对应的模型输出

-output = model(dummy_input)

-# 导出模型

-torch.onnx.export(model, # 模型的名称

- dummy_input, # 一组实例化输入

- onnx_file_name, # 文件保存路径/名称

- export_params=True, # 如果指定为True或默认, 参数也会被导出. 如果你要导出一个没训练过的就设为 False.

- opset_version=10, # ONNX 算子集的版本,当前已更新到15

- do_constant_folding=True, # 是否执行常量折叠优化

- input_names = ['input'], # 输入模型的张量的名称

- output_names = ['output'], # 输出模型的张量的名称

- # dynamic_axes将batch_size的维度指定为动态,

- # 后续进行推理的数据可以与导出的dummy_input的batch_size不同

- dynamic_axes={'input' : {0 : 'batch_size'},

- 'output' : {0 : 'batch_size'}})

-

-```

-

-### 9.1.2.2 ONNX模型的检验

-

-当上述代码运行成功后,我们会得到一个ONNX 模型文件。我们需要检测下我们的模型文件是否可用,我们将通过`onnx.checker.check_model()`进行检验,具体方法如下:

-

-```python

-import onnx

-# 我们可以使用异常处理的方法进行检验

-try:

- # 当我们的模型不可用时,将会报出异常

- onnx.checker.check_model(self.onnx_model)

-except onnx.checker.ValidationError as e:

- print("The model is invalid: %s"%e)

-else:

- # 模型可用时,将不会报出异常,并会输出“The model is valid!”

- print("The model is valid!")

-```

-

-### 9.1.2.3 ONNX可视化

-

-在将模型导出为onnx格式后,我们希望有个工具可以像Tensorboard一样可视化模型来观察每个节点的属性特征。随着`Netron`的出现,我们也可以实现onnx的可视化。

-- Netron下载网址:https://github.com/lutzroeder/netron

-

-

-使用Netron进行可视化后,我们不仅能看到整体模型的架构,还能看到每一个节点的信息。在接下来的内容中我们将以Netron官方提供的[squeezenet](https://netron.app/?url=https://media.githubusercontent.com/media/onnx/models/main/vision/classification/squeezenet/model/squeezenet1.0-3.onnx)为例进行介绍。下面第一幅图截取自squeezenet网络,我们可以看到网络的整体流程和输入。

-

- -

-第二幅图显示了第一个Conv的信息包括kernel_size,strides,input,output等信息,同理当我们点击其他节点时也可以显示该节点的信息。

-

-

-

-## 9.1.3 使用ONNX Runtime进行推理

-

-通过以上的操作,我们已经完成了PyTorch的模型到ONNX模型的转换,并通过Netron可视化和`onnx.checker.check_model()`检查了模型的正确性。在这一步,我们将使用ONNX Runtime运行一下转化后的模型,看一下推理后的结果。

-

-```python

-# 导入onnxruntime

-import onnxruntime

-# 需要进行推理的onnx模型文件名称

-onnx_file_name = "xxxxxx.onnx"

-

-# onnxruntime.InferenceSession用于获取一个 ONNX Runtime 推理器

-ort_session = onnxruntime.InferenceSession(onnx_file_name)

-

-# 构建字典的输入数据,字典的key需要与我们构建onnx模型时的input_names相同

-# 输入的input_img 也需要改变为ndarray格式

-ort_inputs = {'input': input_img}

-# 我们更建议使用下面这种方法,因为避免了手动输入key

-# ort_inputs = {ort_session.get_inputs()[0].name:input_img}

-

-# run是进行模型的推理,第一个参数为输出张量名的列表,一般情况可以设置为None

-# 第二个参数为构建的输入值的字典

-# 由于返回的结果被列表嵌套,因此我们需要进行[0]的索引

-ort_output = ort_session.run(None,ort_inputs)[0]

-# output = {ort_session.get_outputs()[0].name}

-# ort_output = ort_session.run([output], ort_inputs)[0]

-

-```

-

-在上述的步骤中,我们有几个需要注意的点:

-

-1. PyTorch模型的输入为tensor,而ONNX的输入为array,因此我们需要对张量进行变换或者直接将数据读取为array格式,我们可以实现下面的方式进行张量到array的转化。

-

-```python

-def to_numpy(tensor):

- return tensor.detach().cpu().numpy() if tensor.requires_grad else tensor.cpu().numpy()

-```

-

-2. 输入的array的shape应该和我们导出模型的`dummy_input`的shape相同,如果图片大小不一样,我们应该先进行resize操作。

-3. run的结果是一个列表,我们需要进行索引操作才能获得array格式的结果。

-4. 在构建输入的字典时,我们需要注意字典的key应与导出ONNX格式设置的input_name相同,因此我们更建议使用上述的第二种方法构建输入的字典。

-

-## 9.1.4 代码实战

-

-本部分代码选自PyTorch官网示例代码,访问链接可点击下方推荐阅读2进行查看和使用官网提供的Colab对onnx导出进行进一步理解。*如有侵权,可立即删除*

-

-### 1. 定义超分辨模型

-

-```python

-# 导入相关包

-import io

-import numpy as np

-from torch import nn

-import torch.utils.model_zoo as model_zoo

-import torch.onnx

-import torch.nn as nn

-import torch.nn.init as init

-

-# 定义超分辨网络

-class SuperResolutionNet(nn.Module):

- def __init__(self, upscale_factor, inplace=False):

- super(SuperResolutionNet, self).__init__()

-

- self.relu = nn.ReLU(inplace=inplace)

- self.conv1 = nn.Conv2d(1, 64, (5, 5), (1, 1), (2, 2))

- self.conv2 = nn.Conv2d(64, 64, (3, 3), (1, 1), (1, 1))

- self.conv3 = nn.Conv2d(64, 32, (3, 3), (1, 1), (1, 1))

- self.conv4 = nn.Conv2d(32, upscale_factor ** 2, (3, 3), (1, 1), (1, 1))

- self.pixel_shuffle = nn.PixelShuffle(upscale_factor)

-

- self._initialize_weights()

-

- def forward(self, x):

- x = self.relu(self.conv1(x))

- x = self.relu(self.conv2(x))

- x = self.relu(self.conv3(x))

- x = self.pixel_shuffle(self.conv4(x))

- return x

-

- # 模型初始化

- def _initialize_weights(self):

- init.orthogonal_(self.conv1.weight, init.calculate_gain('relu'))

- init.orthogonal_(self.conv2.weight, init.calculate_gain('relu'))

- init.orthogonal_(self.conv3.weight, init.calculate_gain('relu'))

- init.orthogonal_(self.conv4.weight)

-

-# 实例化模型

-torch_model = SuperResolutionNet(upscale_factor=3)

-```

-

-### 2. 模型导出为ONNX格式

-

-```python

-model_url = 'https://s3.amazonaws.com/pytorch/test_data/export/superres_epoch100-44c6958e.pth'

-batch_size = 1 # just a random number

-# 加载预训练得到权重

-map_location = lambda storage, loc: storage

-if torch.cuda.is_available():

- map_location = None

-torch_model.load_state_dict(model_zoo.load_url(model_url, map_location=map_location))

-

-# 将模型设置为推理模式

-torch_model.eval()

-# Input to the model

-x = torch.randn(batch_size, 1, 224, 224, requires_grad=True)

-torch_out = torch_model(x)

-

-# 导出模型

-torch.onnx.export(torch_model, # model being run

- x, # model input (or a tuple for multiple inputs)

- "super_resolution.onnx", # where to save the model (can be a file or file-like object)

- export_params=True, # store the trained parameter weights inside the model file

- opset_version=10, # the ONNX version to export the model to

- do_constant_folding=True, # whether to execute constant folding for optimization

- input_names = ['input'], # the model's input names

- output_names = ['output'], # the model's output names

- # variable length axes

- dynamic_axes={'input' : {0 : 'batch_size'},

- 'output' : {0 : 'batch_size'}})

-```

-

-### 3. 检验ONNX模型

-

-```python

-import onnx

-# 我们可以使用异常处理的方法进行检验

-try:

- # 当我们的模型不可用时,将会报出异常

- onnx.checker.check_model("super_resolution.onnx")

-except onnx.checker.ValidationError as e:

- print("The model is invalid: %s"%e)

-else:

- # 模型可用时,将不会报出异常,并会输出“The model is valid!”

- print("The model is valid!")

-```

-

-### 4. 使用ONNX Runtime进行推理

-

-```python

-import onnxruntime

-

-ort_session = onnxruntime.InferenceSession("super_resolution.onnx")

-

-# 将张量转化为ndarray格式

-def to_numpy(tensor):

- return tensor.detach().cpu().numpy() if tensor.requires_grad else tensor.cpu().numpy()

-

-# 构建输入的字典和计算输出结果

-ort_inputs = {ort_session.get_inputs()[0].name: to_numpy(x)}

-ort_outs = ort_session.run(None, ort_inputs)

-

-# 比较使用PyTorch和ONNX Runtime得出的精度

-np.testing.assert_allclose(to_numpy(torch_out), ort_outs[0], rtol=1e-03, atol=1e-05)

-

-print("Exported model has been tested with ONNXRuntime, and the result looks good!")

-```

-

-### 5. 进行实际预测并可视化

-

-```python

-from PIL import Image

-import torchvision.transforms as transforms

-

-# 读取图片

-img = Image.open("/cat_224x224.jpg")

-# 对图片进行resize操作

-resize = transforms.Resize([224, 224])

-img = resize(img)

-

-img_ycbcr = img.convert('YCbCr')

-img_y, img_cb, img_cr = img_ycbcr.split()

-

-to_tensor = transforms.ToTensor()

-img_y = to_tensor(img_y)

-img_y.unsqueeze_(0)

-# 构建输入的字典并将value转换位array格式

-ort_inputs = {ort_session.get_inputs()[0].name: to_numpy(img_y)}

-ort_outs = ort_session.run(None, ort_inputs)

-img_out_y = ort_outs[0]

-img_out_y = Image.fromarray(np.uint8((img_out_y[0] * 255.0).clip(0, 255)[0]), mode='L')

-

-# 保存最后得到的图片

-final_img = Image.merge(

- "YCbCr", [

- img_out_y,

- img_cb.resize(img_out_y.size, Image.BICUBIC),

- img_cr.resize(img_out_y.size, Image.BICUBIC),

- ]).convert("RGB")

-

-final_img.save("/cat_superres_with_ort.jpg")

-```

-

-## 参考资料

-

-1. [miscroft-将 PyTorch 训练模型转换为 ONNX](https://docs.microsoft.com/zh-cn/windows/ai/windows-ml/tutorials/pytorch-convert-model)

-2. [pytorch- EXPORTING A MODEL FROM PYTORCH TO ONNX AND RUNNING IT USING ONNX RUNTIME](https://pytorch.org/tutorials/advanced/super_resolution_with_onnxruntime.html)

-3. [ONNX tutorials](https://github.com/onnx/tutorials#converting-to-onnx-format)

-

diff --git "a/docs/_sources/\347\254\254\344\271\235\347\253\240/9.1 \345\233\276\345\203\217\345\210\206\347\261\273.md.txt" "b/docs/_sources/\347\254\254\344\271\235\347\253\240/9.1 \345\233\276\345\203\217\345\210\206\347\261\273.md.txt"

deleted file mode 100644

index 94444adf6..000000000

--- "a/docs/_sources/\347\254\254\344\271\235\347\253\240/9.1 \345\233\276\345\203\217\345\210\206\347\261\273.md.txt"

+++ /dev/null

@@ -1 +0,0 @@

-# 9.1 图像分类(补充中)

\ No newline at end of file

diff --git "a/docs/_sources/\347\254\254\344\271\235\347\253\240/9.2 \347\233\256\346\240\207\346\243\200\346\265\213.md.txt" "b/docs/_sources/\347\254\254\344\271\235\347\253\240/9.2 \347\233\256\346\240\207\346\243\200\346\265\213.md.txt"

deleted file mode 100644

index 8d02e7c4e..000000000

--- "a/docs/_sources/\347\254\254\344\271\235\347\253\240/9.2 \347\233\256\346\240\207\346\243\200\346\265\213.md.txt"

+++ /dev/null

@@ -1,23 +0,0 @@

-# 目标检测

-## 目标检测概述

-目标检测是计算机视觉的一个重要任务,根据整张图像内容进行描述,并结合目标物体的特征信息,确定该物体的类别与位置。不同于图像分类任务中我们只需要输出图像中主要物体对象的类标,在目标检测任务中,一张图像里往往含有多个物体对象,我们不仅需要输出这些物体的类标,同时还需要输出这些物体的位置,在表示位置时,我们一般采用目标检测边缘框bounding box进行表示,bounding box是一组坐标值,常见形式为(x1,y1,x2,y2),其中x1代表物体左上x坐标,y1代表左上y坐标,x2代表物体右下x坐标,y2代表物体右下y坐标。

-## 目标检测应用

-目标检测技术不同于图像分类单一输出物体的种类,它将物体的位置和种类一起输出,这使得目标检测在一些领域有着重要的作用,目标检测常用于人脸检测、智慧交通、机器人、无人驾驶、遥感目标检测、安防领域检测异常、行人计数、安全系统等各大领域。

-## 目标检测数据集

-目标检测的数据集通常来说比图片分类的数据集小很多,因为每一张图片的标注的成本很高,相较于图片分类的常见标注方法是给定一个CSV文件(图片与标号一一对应)或者是给定一个文件夹(每个类对应一个子文件夹,对应标号的图片放在子文件夹下),但是对于目标检测来说因为一张图片中可能存在多个类,所以我们就不能放在子文件夹中,所以通常来说目标检测的数据集的标号需要额外存储,常见的存储格式有PASCAL VOC的格式和COCO的标注格式。假设使用文本文件存储的话,每一行表示一个物体,每一行分别由图片文件名(因为一张图片中可能有多个物体,所以同一个文件名可能会出现多次)、物体类别(标号)、边缘框(图片中物体的位置)组成,每一行一共有6(1+1+4)个值

-目标检测常用的数据集有PASCAL VOC2007, MS COCO

-### COCO数据集

-目标检测中比较常见的数据集,类似于Imagenet在图片分类中的地位

-访问地址:https://cocodataset.org/#home

-COCO数据集中有 80 个类别,330k 图片,1.5M 物体(每张图片中有多个物体)

-

-## 目标检测常用算法

-随着算力的发展和深度学习的发展,目标检测经历了从基于手工设计特征的方法到基于深度学习提取特征的阶段。在早期,目标检测技术往往采用手工设计特征(Haar特征、梯度直方图HOG)加分类器(SVM、AdaBoost)的方法实现。随着卷积神经网络的发展,目标检测出现了一系列的基于卷积神经网络的目标检测技术,包括R-CNN系列,SSD系列,YOLO系列等。随着Transformer在自然语言处理和计算机视觉的发展,也出现了基于Transformer的目标检测技术,代表工作有DETR系列。在本部分,我们主要介绍基于深度学习的目标检测技术并进行部分代码的解读。

-我们可以将基于深度学习的目标检测技术按照有无使用锚点框分为基于锚点框的目标检测方法(Anchor-based),无锚点框的目标检测方法(Anchor-free)和端到端的目标检测方法(Anchor-free)。其中端到端的目标检测技术也是属于特殊的无锚点框的目标检测方法。

-我们可以将基于锚点框的目标检测方法分为单阶段目标检测方法(One-Stage)和两阶段目标检测方法(Two-Stage),其中单阶段目标检测方法代表作有YOLO (You Only Look Once)和SSD (Single Shot Detector),两阶段目标检测方法的代表作有R-CNN(R-CNN,Fast RCNN,Faster RCNN,Mask RCNN,Cascade RCNN,SPPNet)系列。一般而言,两阶段目标检测具有较高的检测精度,而单阶段目标检测方法具有更高的精度。

-同样,我们可以将无锚点框的目标检测方法分为基于目标点的目标检测方法和基于内部点的目标检测方法。

-端到端的目标检测方法

-

-

-

-

diff --git "a/docs/_sources/\347\254\254\344\271\235\347\253\240/index.md.txt" "b/docs/_sources/\347\254\254\344\271\235\347\253\240/index.md.txt"

deleted file mode 100644

index 1eae3e7a5..000000000

--- "a/docs/_sources/\347\254\254\344\271\235\347\253\240/index.md.txt"

+++ /dev/null

@@ -1,5 +0,0 @@

-# 第九章:PyTorch的模型部署

-```{toctree}

-:maxdepth: 2

-9.1 使用ONNX进行部署并推理

-```

\ No newline at end of file

diff --git "a/docs/_sources/\347\254\254\344\272\214\347\253\240/2.1 \345\274\240\351\207\217.md.txt" "b/docs/_sources/\347\254\254\344\272\214\347\253\240/2.1 \345\274\240\351\207\217.md.txt"

deleted file mode 100644

index b9e127682..000000000

--- "a/docs/_sources/\347\254\254\344\272\214\347\253\240/2.1 \345\274\240\351\207\217.md.txt"

+++ /dev/null

@@ -1,252 +0,0 @@

-# 2.1 张量

-

-从本章开始,我们将开始介绍PyTorch基础知识,本章我们将介绍张量,以帮助大家建立起对数据的描述,随后我们再介绍张量的运算,最后再讲PyTorch中所有神经网络的核心包 `autograd `,也就是自动微分,了解完这些内容我们就可以较好地理解PyTorch代码了。在深度学习中,我们通常将数据以张量的形式进行表示,比如我们用三维张量表示一个RGB图像,四维张量表示视频。

-

-经过本节的学习,你将收获:

-

-- 张量的简介

-- PyTorch如何创建张量

-- PyTorch中张量的操作

-- PyTorch中张量的广播机制

-

-## 2.1.1 简介

-

-几何代数中定义的张量是基于向量和矩阵的推广,比如我们可以将标量视为零阶张量,矢量可以视为一阶张量,矩阵就是二阶张量。

-|张量维度|代表含义|

-|---|---|

-| 0维张量 | 代表的是标量(数字) |

-| 1维张量 | 代表的是向量|

-| 2维张量 |代表的是矩阵|

-|3维张量 |时间序列数据 股价 文本数据 单张彩色图片(**RGB**)|

-

-张量是现代机器学习的基础。它的核心是一个数据容器,多数情况下,它包含数字,有时候它也包含字符串,但这种情况比较少。因此可以把它想象成一个数字的水桶。

-

-这里有一些存储在各种类型张量的公用数据集类型:

-

-- **3维 = 时间序列**

-- **4维 = 图像**

-- **5维 = 视频**

-

-例子:一个图像可以用三个字段表示:

-

-```

-(width, height, channel) = 3D

-```

-

-但是,在机器学习工作中,我们经常要处理不止一张图片或一篇文档——我们要处理一个集合。我们可能有10,000张郁金香的图片,这意味着,我们将用到4D张量:

-

-```

-(batch_size, width, height, channel) = 4D

-```

-

-在PyTorch中, `torch.Tensor` 是存储和变换数据的主要工具。如果你之前用过`NumPy`,你会发现 `Tensor` 和NumPy的多维数组非常类似。然而,`Tensor` 提供GPU计算和自动求梯度等更多功能,这些使 `Tensor` 这一数据类型更加适合深度学习。

-

-

-## 2.1.2 创建tensor

-在接下来的内容中,我们将介绍几种常见的创建`tensor`的方法。

-

-1. 随机初始化矩阵

-我们可以通过`torch.rand()`的方法,构造一个随机初始化的矩阵:

-

-```python

-

-import torch

-x = torch.rand(4, 3)

-print(x)

-```

-```python

-tensor([[0.7569, 0.4281, 0.4722],

- [0.9513, 0.5168, 0.1659],

- [0.4493, 0.2846, 0.4363],

- [0.5043, 0.9637, 0.1469]])

-```

-2. 全0矩阵的构建

-我们可以通过`torch.zeros()`构造一个矩阵全为 0,并且通过`dtype`设置数据类型为 long。除此以外,我们还可以通过torch.zero_()和torch.zeros_like()将现有矩阵转换为全0矩阵.

-

-```python

-import torch

-x = torch.zeros(4, 3, dtype=torch.long)

-print(x)

-```

-```python

-tensor([[0, 0, 0],

- [0, 0, 0],

- [0, 0, 0],

- [0, 0, 0]])

-```

-3. 张量的构建

- 我们可以通过`torch.tensor()`直接使用数据,构造一个张量:

-```python

-import torch

-x = torch.tensor([5.5, 3])

-print(x)

-```

-```python

-tensor([5.5000, 3.0000])

-```

-4. 基于已经存在的 tensor,创建一个 tensor :

-

-```python

-x = x.new_ones(4, 3, dtype=torch.double)

-# 创建一个新的全1矩阵tensor,返回的tensor默认具有相同的torch.dtype和torch.device

-# 也可以像之前的写法 x = torch.ones(4, 3, dtype=torch.double)

-print(x)

-x = torch.randn_like(x, dtype=torch.float)

-# 重置数据类型

-print(x)

-# 结果会有一样的size

-# 获取它的维度信息

-print(x.size())

-print(x.shape)

-```

-```python

-tensor([[1., 1., 1.],

- [1., 1., 1.],

- [1., 1., 1.],

- [1., 1., 1.]], dtype=torch.float64)

-tensor([[ 2.7311, -0.0720, 0.2497],

- [-2.3141, 0.0666, -0.5934],

- [ 1.5253, 1.0336, 1.3859],

- [ 1.3806, -0.6965, -1.2255]])

-torch.Size([4, 3])

-torch.Size([4, 3])

-```

-返回的torch.Size其实是一个tuple,⽀持所有tuple的操作。我们可以使用索引操作取得张量的长、宽等数据维度。

-

-5. 常见的构造Tensor的方法:

-

-| 函数 | 功能 |

-| --------------------: | --------------------------------------------------- |

-| Tensor(sizes) | 基础构造函数 |

-| tensor(data) | 类似于np.array |

-| ones(sizes) | 全1 |

-| zeros(sizes) | 全0 |

-| eye(sizes) | 对角为1,其余为0 |

-| arange(s,e,step) | 从s到e,步长为step |

-| linspace(s,e,steps) | 从s到e,均匀分成step份 |

-| rand/randn(sizes) | rand是[0,1)均匀分布;randn是服从N(0,1)的正态分布 |

-| normal(mean,std) | 正态分布(均值为mean,标准差是std) |

-| randperm(m) | 随机排列 |

-

-## 2.1.3 张量的操作

-在接下来的内容中,我们将介绍几种常见的张量的操作方法:

-1. 加法操作:

-```python

-import torch

-# 方式1

-y = torch.rand(4, 3)

-print(x + y)

-

-# 方式2

-print(torch.add(x, y))

-

-# 方式3 in-place,原值修改

-y.add_(x)

-print(y)

-```

-```python

-tensor([[ 2.8977, 0.6581, 0.5856],

- [-1.3604, 0.1656, -0.0823],

- [ 2.1387, 1.7959, 1.5275],

- [ 2.2427, -0.3100, -0.4826]])

-tensor([[ 2.8977, 0.6581, 0.5856],

- [-1.3604, 0.1656, -0.0823],

- [ 2.1387, 1.7959, 1.5275],

- [ 2.2427, -0.3100, -0.4826]])

-tensor([[ 2.8977, 0.6581, 0.5856],

- [-1.3604, 0.1656, -0.0823],

- [ 2.1387, 1.7959, 1.5275],

- [ 2.2427, -0.3100, -0.4826]])

-

-```

-2. 索引操作:(类似于numpy)

-

-**需要注意的是:索引出来的结果与原数据共享内存,修改一个,另一个会跟着修改。如果不想修改,可以考虑使用copy()等方法**

-

-```python

-import torch

-x = torch.rand(4,3)

-# 取第二列

-print(x[:, 1])

-```

-```python

-tensor([-0.0720, 0.0666, 1.0336, -0.6965])

-```

-

-```python

-y = x[0,:]

-y += 1

-print(y)

-print(x[0, :]) # 源tensor也被改了了

-```

-```python

-tensor([3.7311, 0.9280, 1.2497])

-tensor([3.7311, 0.9280, 1.2497])

-```

-3. 维度变换

-张量的维度变换常见的方法有`torch.view()`和`torch.reshape()`,下面我们将介绍第一中方法`torch.view()`:

-

-```python

-x = torch.randn(4, 4)

-y = x.view(16)

-z = x.view(-1, 8) # -1是指这一维的维数由其他维度决定

-print(x.size(), y.size(), z.size())

-```

-```python

-torch.Size([4, 4]) torch.Size([16]) torch.Size([2, 8])

-```

-注: `torch.view()` 返回的新`tensor`与源`tensor`共享内存(其实是同一个`tensor`),更改其中的一个,另外一个也会跟着改变。(顾名思义,view()仅仅是改变了对这个张量的观察角度)

-

-```python

-x += 1

-print(x)

-print(y) # 也加了了1

-```

-```python

-tensor([[ 1.3019, 0.3762, 1.2397, 1.3998],

- [ 0.6891, 1.3651, 1.1891, -0.6744],

- [ 0.3490, 1.8377, 1.6456, 0.8403],

- [-0.8259, 2.5454, 1.2474, 0.7884]])

-tensor([ 1.3019, 0.3762, 1.2397, 1.3998, 0.6891, 1.3651, 1.1891, -0.6744,

- 0.3490, 1.8377, 1.6456, 0.8403, -0.8259, 2.5454, 1.2474, 0.7884])

-```

-上面我们说过torch.view()会改变原始张量,但是很多情况下,我们希望原始张量和变换后的张量互相不影响。为为了使创建的张量和原始张量不共享内存,我们需要使用第二种方法`torch.reshape()`, 同样可以改变张量的形状,但是此函数并不能保证返回的是其拷贝值,所以官方不推荐使用。推荐的方法是我们先用 `clone()` 创造一个张量副本然后再使用 `torch.view()`进行函数维度变换 。

-

-注:使用 `clone()` 还有一个好处是会被记录在计算图中,即梯度回传到副本时也会传到源 Tensor 。

-3. 取值操作

-如果我们有一个元素 `tensor` ,我们可以使用 `.item()` 来获得这个 `value`,而不获得其他性质:

-

-```python

-import torch

-x = torch.randn(1)

-print(type(x))

-print(type(x.item()))

-```

-```python

-

-

-第二幅图显示了第一个Conv的信息包括kernel_size,strides,input,output等信息,同理当我们点击其他节点时也可以显示该节点的信息。

-

-

-

-## 9.1.3 使用ONNX Runtime进行推理

-

-通过以上的操作,我们已经完成了PyTorch的模型到ONNX模型的转换,并通过Netron可视化和`onnx.checker.check_model()`检查了模型的正确性。在这一步,我们将使用ONNX Runtime运行一下转化后的模型,看一下推理后的结果。

-

-```python

-# 导入onnxruntime

-import onnxruntime

-# 需要进行推理的onnx模型文件名称

-onnx_file_name = "xxxxxx.onnx"

-

-# onnxruntime.InferenceSession用于获取一个 ONNX Runtime 推理器

-ort_session = onnxruntime.InferenceSession(onnx_file_name)

-

-# 构建字典的输入数据,字典的key需要与我们构建onnx模型时的input_names相同

-# 输入的input_img 也需要改变为ndarray格式

-ort_inputs = {'input': input_img}

-# 我们更建议使用下面这种方法,因为避免了手动输入key

-# ort_inputs = {ort_session.get_inputs()[0].name:input_img}

-

-# run是进行模型的推理,第一个参数为输出张量名的列表,一般情况可以设置为None

-# 第二个参数为构建的输入值的字典

-# 由于返回的结果被列表嵌套,因此我们需要进行[0]的索引

-ort_output = ort_session.run(None,ort_inputs)[0]

-# output = {ort_session.get_outputs()[0].name}

-# ort_output = ort_session.run([output], ort_inputs)[0]

-

-```

-

-在上述的步骤中,我们有几个需要注意的点:

-

-1. PyTorch模型的输入为tensor,而ONNX的输入为array,因此我们需要对张量进行变换或者直接将数据读取为array格式,我们可以实现下面的方式进行张量到array的转化。

-

-```python

-def to_numpy(tensor):

- return tensor.detach().cpu().numpy() if tensor.requires_grad else tensor.cpu().numpy()

-```

-

-2. 输入的array的shape应该和我们导出模型的`dummy_input`的shape相同,如果图片大小不一样,我们应该先进行resize操作。

-3. run的结果是一个列表,我们需要进行索引操作才能获得array格式的结果。

-4. 在构建输入的字典时,我们需要注意字典的key应与导出ONNX格式设置的input_name相同,因此我们更建议使用上述的第二种方法构建输入的字典。

-

-## 9.1.4 代码实战

-

-本部分代码选自PyTorch官网示例代码,访问链接可点击下方推荐阅读2进行查看和使用官网提供的Colab对onnx导出进行进一步理解。*如有侵权,可立即删除*

-

-### 1. 定义超分辨模型

-

-```python

-# 导入相关包

-import io

-import numpy as np

-from torch import nn

-import torch.utils.model_zoo as model_zoo

-import torch.onnx

-import torch.nn as nn

-import torch.nn.init as init

-

-# 定义超分辨网络

-class SuperResolutionNet(nn.Module):

- def __init__(self, upscale_factor, inplace=False):

- super(SuperResolutionNet, self).__init__()

-

- self.relu = nn.ReLU(inplace=inplace)

- self.conv1 = nn.Conv2d(1, 64, (5, 5), (1, 1), (2, 2))

- self.conv2 = nn.Conv2d(64, 64, (3, 3), (1, 1), (1, 1))

- self.conv3 = nn.Conv2d(64, 32, (3, 3), (1, 1), (1, 1))

- self.conv4 = nn.Conv2d(32, upscale_factor ** 2, (3, 3), (1, 1), (1, 1))

- self.pixel_shuffle = nn.PixelShuffle(upscale_factor)

-

- self._initialize_weights()

-

- def forward(self, x):

- x = self.relu(self.conv1(x))

- x = self.relu(self.conv2(x))

- x = self.relu(self.conv3(x))

- x = self.pixel_shuffle(self.conv4(x))

- return x

-

- # 模型初始化

- def _initialize_weights(self):

- init.orthogonal_(self.conv1.weight, init.calculate_gain('relu'))

- init.orthogonal_(self.conv2.weight, init.calculate_gain('relu'))

- init.orthogonal_(self.conv3.weight, init.calculate_gain('relu'))

- init.orthogonal_(self.conv4.weight)

-

-# 实例化模型

-torch_model = SuperResolutionNet(upscale_factor=3)

-```

-

-### 2. 模型导出为ONNX格式

-

-```python

-model_url = 'https://s3.amazonaws.com/pytorch/test_data/export/superres_epoch100-44c6958e.pth'

-batch_size = 1 # just a random number

-# 加载预训练得到权重

-map_location = lambda storage, loc: storage

-if torch.cuda.is_available():

- map_location = None

-torch_model.load_state_dict(model_zoo.load_url(model_url, map_location=map_location))

-

-# 将模型设置为推理模式

-torch_model.eval()

-# Input to the model

-x = torch.randn(batch_size, 1, 224, 224, requires_grad=True)

-torch_out = torch_model(x)

-

-# 导出模型

-torch.onnx.export(torch_model, # model being run

- x, # model input (or a tuple for multiple inputs)

- "super_resolution.onnx", # where to save the model (can be a file or file-like object)

- export_params=True, # store the trained parameter weights inside the model file

- opset_version=10, # the ONNX version to export the model to

- do_constant_folding=True, # whether to execute constant folding for optimization

- input_names = ['input'], # the model's input names

- output_names = ['output'], # the model's output names

- # variable length axes

- dynamic_axes={'input' : {0 : 'batch_size'},

- 'output' : {0 : 'batch_size'}})

-```

-

-### 3. 检验ONNX模型

-

-```python

-import onnx

-# 我们可以使用异常处理的方法进行检验

-try:

- # 当我们的模型不可用时,将会报出异常

- onnx.checker.check_model("super_resolution.onnx")

-except onnx.checker.ValidationError as e:

- print("The model is invalid: %s"%e)

-else:

- # 模型可用时,将不会报出异常,并会输出“The model is valid!”

- print("The model is valid!")

-```

-

-### 4. 使用ONNX Runtime进行推理

-

-```python

-import onnxruntime

-

-ort_session = onnxruntime.InferenceSession("super_resolution.onnx")

-

-# 将张量转化为ndarray格式

-def to_numpy(tensor):

- return tensor.detach().cpu().numpy() if tensor.requires_grad else tensor.cpu().numpy()

-

-# 构建输入的字典和计算输出结果

-ort_inputs = {ort_session.get_inputs()[0].name: to_numpy(x)}

-ort_outs = ort_session.run(None, ort_inputs)

-

-# 比较使用PyTorch和ONNX Runtime得出的精度

-np.testing.assert_allclose(to_numpy(torch_out), ort_outs[0], rtol=1e-03, atol=1e-05)

-

-print("Exported model has been tested with ONNXRuntime, and the result looks good!")

-```

-

-### 5. 进行实际预测并可视化

-

-```python

-from PIL import Image

-import torchvision.transforms as transforms

-

-# 读取图片

-img = Image.open("/cat_224x224.jpg")

-# 对图片进行resize操作

-resize = transforms.Resize([224, 224])

-img = resize(img)

-

-img_ycbcr = img.convert('YCbCr')

-img_y, img_cb, img_cr = img_ycbcr.split()

-

-to_tensor = transforms.ToTensor()

-img_y = to_tensor(img_y)

-img_y.unsqueeze_(0)

-# 构建输入的字典并将value转换位array格式

-ort_inputs = {ort_session.get_inputs()[0].name: to_numpy(img_y)}

-ort_outs = ort_session.run(None, ort_inputs)

-img_out_y = ort_outs[0]

-img_out_y = Image.fromarray(np.uint8((img_out_y[0] * 255.0).clip(0, 255)[0]), mode='L')

-

-# 保存最后得到的图片

-final_img = Image.merge(

- "YCbCr", [

- img_out_y,

- img_cb.resize(img_out_y.size, Image.BICUBIC),

- img_cr.resize(img_out_y.size, Image.BICUBIC),

- ]).convert("RGB")

-

-final_img.save("/cat_superres_with_ort.jpg")

-```

-

-## 参考资料

-

-1. [miscroft-将 PyTorch 训练模型转换为 ONNX](https://docs.microsoft.com/zh-cn/windows/ai/windows-ml/tutorials/pytorch-convert-model)

-2. [pytorch- EXPORTING A MODEL FROM PYTORCH TO ONNX AND RUNNING IT USING ONNX RUNTIME](https://pytorch.org/tutorials/advanced/super_resolution_with_onnxruntime.html)

-3. [ONNX tutorials](https://github.com/onnx/tutorials#converting-to-onnx-format)

-

diff --git "a/docs/_sources/\347\254\254\344\271\235\347\253\240/9.1 \345\233\276\345\203\217\345\210\206\347\261\273.md.txt" "b/docs/_sources/\347\254\254\344\271\235\347\253\240/9.1 \345\233\276\345\203\217\345\210\206\347\261\273.md.txt"

deleted file mode 100644

index 94444adf6..000000000

--- "a/docs/_sources/\347\254\254\344\271\235\347\253\240/9.1 \345\233\276\345\203\217\345\210\206\347\261\273.md.txt"

+++ /dev/null

@@ -1 +0,0 @@

-# 9.1 图像分类(补充中)

\ No newline at end of file

diff --git "a/docs/_sources/\347\254\254\344\271\235\347\253\240/9.2 \347\233\256\346\240\207\346\243\200\346\265\213.md.txt" "b/docs/_sources/\347\254\254\344\271\235\347\253\240/9.2 \347\233\256\346\240\207\346\243\200\346\265\213.md.txt"

deleted file mode 100644

index 8d02e7c4e..000000000

--- "a/docs/_sources/\347\254\254\344\271\235\347\253\240/9.2 \347\233\256\346\240\207\346\243\200\346\265\213.md.txt"

+++ /dev/null

@@ -1,23 +0,0 @@

-# 目标检测

-## 目标检测概述

-目标检测是计算机视觉的一个重要任务,根据整张图像内容进行描述,并结合目标物体的特征信息,确定该物体的类别与位置。不同于图像分类任务中我们只需要输出图像中主要物体对象的类标,在目标检测任务中,一张图像里往往含有多个物体对象,我们不仅需要输出这些物体的类标,同时还需要输出这些物体的位置,在表示位置时,我们一般采用目标检测边缘框bounding box进行表示,bounding box是一组坐标值,常见形式为(x1,y1,x2,y2),其中x1代表物体左上x坐标,y1代表左上y坐标,x2代表物体右下x坐标,y2代表物体右下y坐标。

-## 目标检测应用

-目标检测技术不同于图像分类单一输出物体的种类,它将物体的位置和种类一起输出,这使得目标检测在一些领域有着重要的作用,目标检测常用于人脸检测、智慧交通、机器人、无人驾驶、遥感目标检测、安防领域检测异常、行人计数、安全系统等各大领域。

-## 目标检测数据集

-目标检测的数据集通常来说比图片分类的数据集小很多,因为每一张图片的标注的成本很高,相较于图片分类的常见标注方法是给定一个CSV文件(图片与标号一一对应)或者是给定一个文件夹(每个类对应一个子文件夹,对应标号的图片放在子文件夹下),但是对于目标检测来说因为一张图片中可能存在多个类,所以我们就不能放在子文件夹中,所以通常来说目标检测的数据集的标号需要额外存储,常见的存储格式有PASCAL VOC的格式和COCO的标注格式。假设使用文本文件存储的话,每一行表示一个物体,每一行分别由图片文件名(因为一张图片中可能有多个物体,所以同一个文件名可能会出现多次)、物体类别(标号)、边缘框(图片中物体的位置)组成,每一行一共有6(1+1+4)个值

-目标检测常用的数据集有PASCAL VOC2007, MS COCO

-### COCO数据集

-目标检测中比较常见的数据集,类似于Imagenet在图片分类中的地位

-访问地址:https://cocodataset.org/#home

-COCO数据集中有 80 个类别,330k 图片,1.5M 物体(每张图片中有多个物体)

-

-## 目标检测常用算法

-随着算力的发展和深度学习的发展,目标检测经历了从基于手工设计特征的方法到基于深度学习提取特征的阶段。在早期,目标检测技术往往采用手工设计特征(Haar特征、梯度直方图HOG)加分类器(SVM、AdaBoost)的方法实现。随着卷积神经网络的发展,目标检测出现了一系列的基于卷积神经网络的目标检测技术,包括R-CNN系列,SSD系列,YOLO系列等。随着Transformer在自然语言处理和计算机视觉的发展,也出现了基于Transformer的目标检测技术,代表工作有DETR系列。在本部分,我们主要介绍基于深度学习的目标检测技术并进行部分代码的解读。

-我们可以将基于深度学习的目标检测技术按照有无使用锚点框分为基于锚点框的目标检测方法(Anchor-based),无锚点框的目标检测方法(Anchor-free)和端到端的目标检测方法(Anchor-free)。其中端到端的目标检测技术也是属于特殊的无锚点框的目标检测方法。

-我们可以将基于锚点框的目标检测方法分为单阶段目标检测方法(One-Stage)和两阶段目标检测方法(Two-Stage),其中单阶段目标检测方法代表作有YOLO (You Only Look Once)和SSD (Single Shot Detector),两阶段目标检测方法的代表作有R-CNN(R-CNN,Fast RCNN,Faster RCNN,Mask RCNN,Cascade RCNN,SPPNet)系列。一般而言,两阶段目标检测具有较高的检测精度,而单阶段目标检测方法具有更高的精度。

-同样,我们可以将无锚点框的目标检测方法分为基于目标点的目标检测方法和基于内部点的目标检测方法。

-端到端的目标检测方法

-

-

-

-

diff --git "a/docs/_sources/\347\254\254\344\271\235\347\253\240/index.md.txt" "b/docs/_sources/\347\254\254\344\271\235\347\253\240/index.md.txt"

deleted file mode 100644

index 1eae3e7a5..000000000

--- "a/docs/_sources/\347\254\254\344\271\235\347\253\240/index.md.txt"

+++ /dev/null

@@ -1,5 +0,0 @@

-# 第九章:PyTorch的模型部署

-```{toctree}

-:maxdepth: 2

-9.1 使用ONNX进行部署并推理

-```

\ No newline at end of file

diff --git "a/docs/_sources/\347\254\254\344\272\214\347\253\240/2.1 \345\274\240\351\207\217.md.txt" "b/docs/_sources/\347\254\254\344\272\214\347\253\240/2.1 \345\274\240\351\207\217.md.txt"

deleted file mode 100644

index b9e127682..000000000

--- "a/docs/_sources/\347\254\254\344\272\214\347\253\240/2.1 \345\274\240\351\207\217.md.txt"

+++ /dev/null

@@ -1,252 +0,0 @@

-# 2.1 张量

-

-从本章开始,我们将开始介绍PyTorch基础知识,本章我们将介绍张量,以帮助大家建立起对数据的描述,随后我们再介绍张量的运算,最后再讲PyTorch中所有神经网络的核心包 `autograd `,也就是自动微分,了解完这些内容我们就可以较好地理解PyTorch代码了。在深度学习中,我们通常将数据以张量的形式进行表示,比如我们用三维张量表示一个RGB图像,四维张量表示视频。

-

-经过本节的学习,你将收获:

-

-- 张量的简介

-- PyTorch如何创建张量

-- PyTorch中张量的操作

-- PyTorch中张量的广播机制

-

-## 2.1.1 简介

-

-几何代数中定义的张量是基于向量和矩阵的推广,比如我们可以将标量视为零阶张量,矢量可以视为一阶张量,矩阵就是二阶张量。

-|张量维度|代表含义|

-|---|---|

-| 0维张量 | 代表的是标量(数字) |

-| 1维张量 | 代表的是向量|

-| 2维张量 |代表的是矩阵|

-|3维张量 |时间序列数据 股价 文本数据 单张彩色图片(**RGB**)|

-

-张量是现代机器学习的基础。它的核心是一个数据容器,多数情况下,它包含数字,有时候它也包含字符串,但这种情况比较少。因此可以把它想象成一个数字的水桶。

-

-这里有一些存储在各种类型张量的公用数据集类型:

-

-- **3维 = 时间序列**

-- **4维 = 图像**

-- **5维 = 视频**

-

-例子:一个图像可以用三个字段表示:

-

-```

-(width, height, channel) = 3D

-```

-

-但是,在机器学习工作中,我们经常要处理不止一张图片或一篇文档——我们要处理一个集合。我们可能有10,000张郁金香的图片,这意味着,我们将用到4D张量:

-

-```

-(batch_size, width, height, channel) = 4D

-```

-

-在PyTorch中, `torch.Tensor` 是存储和变换数据的主要工具。如果你之前用过`NumPy`,你会发现 `Tensor` 和NumPy的多维数组非常类似。然而,`Tensor` 提供GPU计算和自动求梯度等更多功能,这些使 `Tensor` 这一数据类型更加适合深度学习。

-

-

-## 2.1.2 创建tensor

-在接下来的内容中,我们将介绍几种常见的创建`tensor`的方法。

-

-1. 随机初始化矩阵

-我们可以通过`torch.rand()`的方法,构造一个随机初始化的矩阵:

-

-```python

-

-import torch

-x = torch.rand(4, 3)

-print(x)

-```

-```python

-tensor([[0.7569, 0.4281, 0.4722],

- [0.9513, 0.5168, 0.1659],

- [0.4493, 0.2846, 0.4363],

- [0.5043, 0.9637, 0.1469]])

-```

-2. 全0矩阵的构建

-我们可以通过`torch.zeros()`构造一个矩阵全为 0,并且通过`dtype`设置数据类型为 long。除此以外,我们还可以通过torch.zero_()和torch.zeros_like()将现有矩阵转换为全0矩阵.

-

-```python

-import torch

-x = torch.zeros(4, 3, dtype=torch.long)

-print(x)

-```

-```python

-tensor([[0, 0, 0],

- [0, 0, 0],

- [0, 0, 0],

- [0, 0, 0]])

-```

-3. 张量的构建

- 我们可以通过`torch.tensor()`直接使用数据,构造一个张量:

-```python

-import torch

-x = torch.tensor([5.5, 3])

-print(x)

-```

-```python

-tensor([5.5000, 3.0000])

-```

-4. 基于已经存在的 tensor,创建一个 tensor :

-

-```python

-x = x.new_ones(4, 3, dtype=torch.double)

-# 创建一个新的全1矩阵tensor,返回的tensor默认具有相同的torch.dtype和torch.device

-# 也可以像之前的写法 x = torch.ones(4, 3, dtype=torch.double)

-print(x)

-x = torch.randn_like(x, dtype=torch.float)

-# 重置数据类型

-print(x)

-# 结果会有一样的size

-# 获取它的维度信息

-print(x.size())

-print(x.shape)

-```

-```python

-tensor([[1., 1., 1.],

- [1., 1., 1.],

- [1., 1., 1.],

- [1., 1., 1.]], dtype=torch.float64)

-tensor([[ 2.7311, -0.0720, 0.2497],

- [-2.3141, 0.0666, -0.5934],

- [ 1.5253, 1.0336, 1.3859],

- [ 1.3806, -0.6965, -1.2255]])

-torch.Size([4, 3])

-torch.Size([4, 3])

-```

-返回的torch.Size其实是一个tuple,⽀持所有tuple的操作。我们可以使用索引操作取得张量的长、宽等数据维度。

-

-5. 常见的构造Tensor的方法:

-

-| 函数 | 功能 |

-| --------------------: | --------------------------------------------------- |

-| Tensor(sizes) | 基础构造函数 |

-| tensor(data) | 类似于np.array |

-| ones(sizes) | 全1 |

-| zeros(sizes) | 全0 |

-| eye(sizes) | 对角为1,其余为0 |

-| arange(s,e,step) | 从s到e,步长为step |

-| linspace(s,e,steps) | 从s到e,均匀分成step份 |

-| rand/randn(sizes) | rand是[0,1)均匀分布;randn是服从N(0,1)的正态分布 |

-| normal(mean,std) | 正态分布(均值为mean,标准差是std) |

-| randperm(m) | 随机排列 |

-

-## 2.1.3 张量的操作

-在接下来的内容中,我们将介绍几种常见的张量的操作方法:

-1. 加法操作:

-```python

-import torch

-# 方式1

-y = torch.rand(4, 3)

-print(x + y)

-

-# 方式2

-print(torch.add(x, y))

-

-# 方式3 in-place,原值修改

-y.add_(x)

-print(y)

-```

-```python

-tensor([[ 2.8977, 0.6581, 0.5856],

- [-1.3604, 0.1656, -0.0823],

- [ 2.1387, 1.7959, 1.5275],

- [ 2.2427, -0.3100, -0.4826]])

-tensor([[ 2.8977, 0.6581, 0.5856],

- [-1.3604, 0.1656, -0.0823],

- [ 2.1387, 1.7959, 1.5275],

- [ 2.2427, -0.3100, -0.4826]])

-tensor([[ 2.8977, 0.6581, 0.5856],

- [-1.3604, 0.1656, -0.0823],

- [ 2.1387, 1.7959, 1.5275],

- [ 2.2427, -0.3100, -0.4826]])

-

-```

-2. 索引操作:(类似于numpy)

-

-**需要注意的是:索引出来的结果与原数据共享内存,修改一个,另一个会跟着修改。如果不想修改,可以考虑使用copy()等方法**

-

-```python

-import torch

-x = torch.rand(4,3)

-# 取第二列

-print(x[:, 1])

-```

-```python

-tensor([-0.0720, 0.0666, 1.0336, -0.6965])

-```

-

-```python

-y = x[0,:]

-y += 1

-print(y)

-print(x[0, :]) # 源tensor也被改了了

-```

-```python

-tensor([3.7311, 0.9280, 1.2497])

-tensor([3.7311, 0.9280, 1.2497])

-```

-3. 维度变换

-张量的维度变换常见的方法有`torch.view()`和`torch.reshape()`,下面我们将介绍第一中方法`torch.view()`:

-

-```python

-x = torch.randn(4, 4)

-y = x.view(16)

-z = x.view(-1, 8) # -1是指这一维的维数由其他维度决定

-print(x.size(), y.size(), z.size())

-```

-```python

-torch.Size([4, 4]) torch.Size([16]) torch.Size([2, 8])

-```

-注: `torch.view()` 返回的新`tensor`与源`tensor`共享内存(其实是同一个`tensor`),更改其中的一个,另外一个也会跟着改变。(顾名思义,view()仅仅是改变了对这个张量的观察角度)

-

-```python

-x += 1

-print(x)

-print(y) # 也加了了1

-```

-```python

-tensor([[ 1.3019, 0.3762, 1.2397, 1.3998],

- [ 0.6891, 1.3651, 1.1891, -0.6744],

- [ 0.3490, 1.8377, 1.6456, 0.8403],

- [-0.8259, 2.5454, 1.2474, 0.7884]])

-tensor([ 1.3019, 0.3762, 1.2397, 1.3998, 0.6891, 1.3651, 1.1891, -0.6744,

- 0.3490, 1.8377, 1.6456, 0.8403, -0.8259, 2.5454, 1.2474, 0.7884])

-```

-上面我们说过torch.view()会改变原始张量,但是很多情况下,我们希望原始张量和变换后的张量互相不影响。为为了使创建的张量和原始张量不共享内存,我们需要使用第二种方法`torch.reshape()`, 同样可以改变张量的形状,但是此函数并不能保证返回的是其拷贝值,所以官方不推荐使用。推荐的方法是我们先用 `clone()` 创造一个张量副本然后再使用 `torch.view()`进行函数维度变换 。

-

-注:使用 `clone()` 还有一个好处是会被记录在计算图中,即梯度回传到副本时也会传到源 Tensor 。

-3. 取值操作

-如果我们有一个元素 `tensor` ,我们可以使用 `.item()` 来获得这个 `value`,而不获得其他性质:

-

-```python

-import torch

-x = torch.randn(1)

-print(type(x))

-print(type(x.item()))

-```

-```python

- -

-上图:In-datacenter performance analysis of a tensor processing unit,figure 1

-

-由上图可见,整个TPU中最重要的计算单元是右上角黄色的矩阵乘单元“Matrix Multiply Unit”,它包含256x256个MAC部件,每一个能够执行有符号或者无符号的8位乘加操作。它的输入为权重数据队列FIFO和统一缓冲Unified Buffer,即图中指向它的两个蓝色部分。在计算结束后,16位结果被收集并传递到位于矩阵单元下方的4MiB 32位蓝色累加器Accumulators中,之后由黄色的激活单元在累加后执行非线性函数,并最终将数据返回给统一缓冲。

-

-Matrix Multiply Unit矩阵处理器作为TPU的核心部分,它可以在单个时钟周期内处理数十万次矩阵(Matrix)运算。MMU有着与传统CPU、GPU截然不同的架构,称为脉动阵列(systolic array)。之所以叫“脉动”,是因为在这种结构中,数据一波一波地流过芯片,与心脏跳动供血的方式类似。而如下图所示,CPU和GPU在每次运算中都需要从多个寄存器(register)中进行存取,而TPU的脉动阵列将多个运算逻辑单元(ALU)串联在一起,复用从一个寄存器中读取的结果。每个ALU单元结构简单,一般只包含乘法器、加法器以及寄存器三部分,适合大量堆砌。

-

-

-

-但是,在极大增加数据复用、降低内存带宽压力的同时,脉动阵列也有两个缺点,即数据重排和规模适配。第一,脉动矩阵主要实现向量/矩阵乘法。以CNN计算为例,CNN数据进入脉动阵列需要调整好形式,并且严格遵循时钟节拍和空间顺序输入。数据重排的额外操作增加了复杂性。第二,在数据流经整个阵列后,才能输出结果。当计算的向量中元素过少,脉动阵列规模过大时,不仅难以将阵列中的每个单元都利用起来,数据的导入和导出延时也随着尺寸扩大而增加,降低了计算效率。因此在确定脉动阵列的规模时,在考虑面积、能耗、峰值计算能力的同时,还要考虑典型应用下的效率。

-

-### 技术特点

-

-#### AI加速专用

-

-TPU的架构属于Domain-specific Architecture,也就是特定领域架构。它的定位准确,架构简单,单线程控制,定制指令集使得它在深度学习运算方面效率极高,且容易扩展。相比之下,传统诸如CPU、GPU等通用处理器必须考虑灵活性和兼容性,有太重的包袱。但TPU这种特点也决定它只能被限制用于深度学习加速场景。

-

-#### 脉动阵列设计

-

-TPU采用了与传统CPU和GPU截然不同的脉动阵列(systolic array)结构来加速AI运算,脉动阵列能够在一个时钟周期内处理数十万次矩阵运算,在每次运算过程中,TPU能够将多个运算逻辑单元(ALU)串联在一起,并复用从一个寄存器中取得的结果。这种设计,不仅能够将数据复用实现最大化,减少芯片在运算过程中的内存访问次数,提高AI计算效率,同时也降低了内存带宽压力,进而降低内存访问的能耗。

-

-MMU的脉动阵列包含256 × 256 = 65,536个ALU,也就是说TPU每个周期可以处理65,536次8位整数的乘法和加法。

-

-TPU以700兆赫兹的功率运行,也就是说,它每秒可以运行65,536 × 700,000,000 = 46 × 1012次乘法和加法运算,或每秒92万亿(92 × 1012)次矩阵单元中的运算。

-

-

-

-上图:In-datacenter performance analysis of a tensor processing unit,figure 1

-

-由上图可见,整个TPU中最重要的计算单元是右上角黄色的矩阵乘单元“Matrix Multiply Unit”,它包含256x256个MAC部件,每一个能够执行有符号或者无符号的8位乘加操作。它的输入为权重数据队列FIFO和统一缓冲Unified Buffer,即图中指向它的两个蓝色部分。在计算结束后,16位结果被收集并传递到位于矩阵单元下方的4MiB 32位蓝色累加器Accumulators中,之后由黄色的激活单元在累加后执行非线性函数,并最终将数据返回给统一缓冲。

-

-Matrix Multiply Unit矩阵处理器作为TPU的核心部分,它可以在单个时钟周期内处理数十万次矩阵(Matrix)运算。MMU有着与传统CPU、GPU截然不同的架构,称为脉动阵列(systolic array)。之所以叫“脉动”,是因为在这种结构中,数据一波一波地流过芯片,与心脏跳动供血的方式类似。而如下图所示,CPU和GPU在每次运算中都需要从多个寄存器(register)中进行存取,而TPU的脉动阵列将多个运算逻辑单元(ALU)串联在一起,复用从一个寄存器中读取的结果。每个ALU单元结构简单,一般只包含乘法器、加法器以及寄存器三部分,适合大量堆砌。

-

-

-

-但是,在极大增加数据复用、降低内存带宽压力的同时,脉动阵列也有两个缺点,即数据重排和规模适配。第一,脉动矩阵主要实现向量/矩阵乘法。以CNN计算为例,CNN数据进入脉动阵列需要调整好形式,并且严格遵循时钟节拍和空间顺序输入。数据重排的额外操作增加了复杂性。第二,在数据流经整个阵列后,才能输出结果。当计算的向量中元素过少,脉动阵列规模过大时,不仅难以将阵列中的每个单元都利用起来,数据的导入和导出延时也随着尺寸扩大而增加,降低了计算效率。因此在确定脉动阵列的规模时,在考虑面积、能耗、峰值计算能力的同时,还要考虑典型应用下的效率。

-

-### 技术特点

-

-#### AI加速专用

-

-TPU的架构属于Domain-specific Architecture,也就是特定领域架构。它的定位准确,架构简单,单线程控制,定制指令集使得它在深度学习运算方面效率极高,且容易扩展。相比之下,传统诸如CPU、GPU等通用处理器必须考虑灵活性和兼容性,有太重的包袱。但TPU这种特点也决定它只能被限制用于深度学习加速场景。

-

-#### 脉动阵列设计

-

-TPU采用了与传统CPU和GPU截然不同的脉动阵列(systolic array)结构来加速AI运算,脉动阵列能够在一个时钟周期内处理数十万次矩阵运算,在每次运算过程中,TPU能够将多个运算逻辑单元(ALU)串联在一起,并复用从一个寄存器中取得的结果。这种设计,不仅能够将数据复用实现最大化,减少芯片在运算过程中的内存访问次数,提高AI计算效率,同时也降低了内存带宽压力,进而降低内存访问的能耗。

-

-MMU的脉动阵列包含256 × 256 = 65,536个ALU,也就是说TPU每个周期可以处理65,536次8位整数的乘法和加法。

-

-TPU以700兆赫兹的功率运行,也就是说,它每秒可以运行65,536 × 700,000,000 = 46 × 1012次乘法和加法运算,或每秒92万亿(92 × 1012)次矩阵单元中的运算。

-

- -

-上图:In-datacenter performance analysis of a tensor processing unit,figure 4

-

-#### 确定性功能和大规模片上内存

-

-如图是TPU的平面设计简图,黄色为MMU运算单元,蓝色是统一缓存和累加器等数据单元,绿色是I/O,红色是逻辑控制单元。

-

-

-

-上图:In-datacenter performance analysis of a tensor processing unit,figure 4

-

-#### 确定性功能和大规模片上内存

-

-如图是TPU的平面设计简图,黄色为MMU运算单元,蓝色是统一缓存和累加器等数据单元,绿色是I/O,红色是逻辑控制单元。

-

- -

-上图:In-datacenter performance analysis of a tensor processing unit,figure 2

-

-传统GPU由于片上内存较少,因此在运行过程中需要不断地去访问片外动态随机存取存储器(DRAM),从而在一定程度上浪费了不必要的能耗。与CPU和GPU相比,TPU的控制单元更小,更容易设计,面积只占了整个冲模的2%,给片上存储器和运算单元留下了更大的空间。如上图所示的TPU一代架构中,总共设计了占总芯片面积35%的内存,其中包括24MB的局部内存、4MB的累加器内存,以及用于与主控处理器对接的内存。这一比例大大超出了GPU等通用处理器,节约了大量片外数据访存能耗,使得TPU计算的能效比大大提高。从TPU二代开始采用HBM片上高带宽内存,虽然和最新一代GPU片上内存技术相同,但是TPU芯片的面积要远远小于GPU。硅片越小,成本越低,良品率也越高。

-

-另外,由于TPU是一个单用途芯片,不需要考虑缓存、分支预测、多道处理等问题。这就意味着TPU的功能是单一且确定的。因此,我们可以使用TPU轻易的预测运行一个神经网络需要多长时间,这样我们就能让芯片以吞吐量接近峰值的状态运行,同时严格控制延迟。

-

-## 2.4.2 NPU

-

-NPU即Neural-network Processing Unit,中文名为神经网络处理器,它采用“数据驱动并行计算”的架构,特别擅长处理视频、图像类的海量多媒体数据。

-

-长期以来,应用需求一直牵动着嵌入式技术的发展方向。随着深度学习神经网络的兴起,人工智能、大数据时代的来临,CPU和GPU渐渐难以满足深度学习的需要,面对日渐旺盛的需求和广大的预期市场,设计一款专门用于神经网络深度学习的高效智能处理器显得十分必要,因此NPU应运而生。

-

-从技术角度看,深度学习实际上是一类多层大规模人工神经网络。它模仿生物神经网络而构建,由若干人工神经元结点互联而成。神经元之间通过突触两两连接,突触记录了神经元间联系的权值强弱。由于深度学习的基本操作是神经元和突触的处理,神经网络中存储和处理是一体化的,都是通过突触权重来体现,而冯·诺伊曼结构中,存储和处理是分离的,分别由存储器和运算器来实现,二者之间存在巨大的差异。当用现有的基于冯·诺伊曼结构的经典计算机(如X86处理器和英伟达GPU)运行神经网络应用时,就不可避免地受到存储和处理分离式结构的制约,因而影响效率。因此,专门针对人工智能的专业芯片NPU更有研发的必要和需求。

-

-在NPU的设计上,中国走在了世界前列。下面我们将以寒武纪的DianNao系列架构为例,来简要介绍NPU。

-

-### DianNao

-

-

-

-

-

-上图:DianNao: a small-footprint high-throughput accelerator for ubiquitous machine-learning,figure 9

-

-基于神经网络的人工智能算法,是模拟人类大脑内部神经元的结构。上图中的neuron代表的就是单个神经元,synapse代表神经元的突触。这个模型的工作模式,就要结合高中生物课的知识了。

-

-一个神经元,有许多突触,给别的神经元传递信息。同样,这个神经元,也会接收来自许多其他神经元的信息。这个神经元所有接受到的信息累加,会有一个强烈程度,在生物上是以化学成分的形式存在,当这些信息达到一定的强烈程度,就会使整个神经元处于兴奋状态(激活),否则就是不兴奋(不激活)。如果兴奋了,就给其他神经元传递信息,如果不兴奋,就不传递。这就是单独一个神经元的工作模式。那么有成千上万个这样的神经元组合起来,就是一个神经网络模型。

-

-那么DianNao是如何模拟神经元进行工作的呢,我们可以看看它的内部结构图:

-

-

-

-上图:DianNao: a small-footprint high-throughput accelerator for ubiquitous machine-learning,figure 11

-

-如图所示,上图中浅蓝色的部分就是用硬件逻辑模拟的神经网络架构,称为NFU(Neural Functional Units)。它可以被细分为三个部分,即途中的NFU-1,NFU-2,和NFU-3。

-

-NFU-1是乘法单元,它采用16bit定点数乘法器,1位符号位,5位整数位,10位小数位。该部分总计有256个乘法器。这些乘法器的计算是同时的,也就是说,在一个周期内可以执行256次乘法。

-

-NFU-2是加法树,总计16个,每一个加法树都是8-4-2-1这样的组成结构,即就是每一个加法树中都有15个加法器。

-

-NFU-3是非线性激活函数,该部分由分段线性近似实现非线性函数,根据前面两个单元计算得到的刺激量,从而判断是否需要激活操作。

-

-当需要实现向量相乘和卷积运算时,使用NFU-1完成对应位置元素相乘,NFU-2完成相乘结果相加,最后由NFU-3完成激活函数映射。完成池化运算时,使用NFU-2完成多个元素取最大值或取平均值运算。由此分析,尽管该运算模块非常简单,也覆盖了神经网络所需要的大部分运算。

-

-### DaDianNao

-

-作为DianNao的多核升级版本,DaDianNao的运算单元NFU与DianNao基本相同,最大的区别是为了完成训练任务多加了几条数据通路,且配置更加灵活。NFU的尺寸为16x16,即16个输出神经元,每个输出神经元有16个输入(输入端需要一次提供256个数据)。同时,NFU可以可选的跳过一些步骤以达到灵活可配置的功能。DaDianNao的NFU结构如下所示:

-

-

-

-上图:DaDianNao: A Machine-Learning Supercomputer,figure 6

-

-### ShiDianNao

-

-ShiDianNao是机器视觉专用加速器,集成了视频处理的部分,它也是DianNao系列中唯一一个考虑运算单元级数据重用的加速器,也是唯一使用二维运算阵列的加速器,其加速器的运算阵列结构如下所示:

-

-

-

-上图:In-datacenter performance analysis of a tensor processing unit,figure 2

-

-传统GPU由于片上内存较少,因此在运行过程中需要不断地去访问片外动态随机存取存储器(DRAM),从而在一定程度上浪费了不必要的能耗。与CPU和GPU相比,TPU的控制单元更小,更容易设计,面积只占了整个冲模的2%,给片上存储器和运算单元留下了更大的空间。如上图所示的TPU一代架构中,总共设计了占总芯片面积35%的内存,其中包括24MB的局部内存、4MB的累加器内存,以及用于与主控处理器对接的内存。这一比例大大超出了GPU等通用处理器,节约了大量片外数据访存能耗,使得TPU计算的能效比大大提高。从TPU二代开始采用HBM片上高带宽内存,虽然和最新一代GPU片上内存技术相同,但是TPU芯片的面积要远远小于GPU。硅片越小,成本越低,良品率也越高。

-

-另外,由于TPU是一个单用途芯片,不需要考虑缓存、分支预测、多道处理等问题。这就意味着TPU的功能是单一且确定的。因此,我们可以使用TPU轻易的预测运行一个神经网络需要多长时间,这样我们就能让芯片以吞吐量接近峰值的状态运行,同时严格控制延迟。

-

-## 2.4.2 NPU

-

-NPU即Neural-network Processing Unit,中文名为神经网络处理器,它采用“数据驱动并行计算”的架构,特别擅长处理视频、图像类的海量多媒体数据。

-

-长期以来,应用需求一直牵动着嵌入式技术的发展方向。随着深度学习神经网络的兴起,人工智能、大数据时代的来临,CPU和GPU渐渐难以满足深度学习的需要,面对日渐旺盛的需求和广大的预期市场,设计一款专门用于神经网络深度学习的高效智能处理器显得十分必要,因此NPU应运而生。

-

-从技术角度看,深度学习实际上是一类多层大规模人工神经网络。它模仿生物神经网络而构建,由若干人工神经元结点互联而成。神经元之间通过突触两两连接,突触记录了神经元间联系的权值强弱。由于深度学习的基本操作是神经元和突触的处理,神经网络中存储和处理是一体化的,都是通过突触权重来体现,而冯·诺伊曼结构中,存储和处理是分离的,分别由存储器和运算器来实现,二者之间存在巨大的差异。当用现有的基于冯·诺伊曼结构的经典计算机(如X86处理器和英伟达GPU)运行神经网络应用时,就不可避免地受到存储和处理分离式结构的制约,因而影响效率。因此,专门针对人工智能的专业芯片NPU更有研发的必要和需求。

-

-在NPU的设计上,中国走在了世界前列。下面我们将以寒武纪的DianNao系列架构为例,来简要介绍NPU。

-

-### DianNao

-

-

-

-

-

-上图:DianNao: a small-footprint high-throughput accelerator for ubiquitous machine-learning,figure 9

-

-基于神经网络的人工智能算法,是模拟人类大脑内部神经元的结构。上图中的neuron代表的就是单个神经元,synapse代表神经元的突触。这个模型的工作模式,就要结合高中生物课的知识了。

-

-一个神经元,有许多突触,给别的神经元传递信息。同样,这个神经元,也会接收来自许多其他神经元的信息。这个神经元所有接受到的信息累加,会有一个强烈程度,在生物上是以化学成分的形式存在,当这些信息达到一定的强烈程度,就会使整个神经元处于兴奋状态(激活),否则就是不兴奋(不激活)。如果兴奋了,就给其他神经元传递信息,如果不兴奋,就不传递。这就是单独一个神经元的工作模式。那么有成千上万个这样的神经元组合起来,就是一个神经网络模型。

-

-那么DianNao是如何模拟神经元进行工作的呢,我们可以看看它的内部结构图:

-

-

-

-上图:DianNao: a small-footprint high-throughput accelerator for ubiquitous machine-learning,figure 11

-

-如图所示,上图中浅蓝色的部分就是用硬件逻辑模拟的神经网络架构,称为NFU(Neural Functional Units)。它可以被细分为三个部分,即途中的NFU-1,NFU-2,和NFU-3。

-

-NFU-1是乘法单元,它采用16bit定点数乘法器,1位符号位,5位整数位,10位小数位。该部分总计有256个乘法器。这些乘法器的计算是同时的,也就是说,在一个周期内可以执行256次乘法。

-

-NFU-2是加法树,总计16个,每一个加法树都是8-4-2-1这样的组成结构,即就是每一个加法树中都有15个加法器。

-

-NFU-3是非线性激活函数,该部分由分段线性近似实现非线性函数,根据前面两个单元计算得到的刺激量,从而判断是否需要激活操作。

-

-当需要实现向量相乘和卷积运算时,使用NFU-1完成对应位置元素相乘,NFU-2完成相乘结果相加,最后由NFU-3完成激活函数映射。完成池化运算时,使用NFU-2完成多个元素取最大值或取平均值运算。由此分析,尽管该运算模块非常简单,也覆盖了神经网络所需要的大部分运算。

-

-### DaDianNao

-

-作为DianNao的多核升级版本,DaDianNao的运算单元NFU与DianNao基本相同,最大的区别是为了完成训练任务多加了几条数据通路,且配置更加灵活。NFU的尺寸为16x16,即16个输出神经元,每个输出神经元有16个输入(输入端需要一次提供256个数据)。同时,NFU可以可选的跳过一些步骤以达到灵活可配置的功能。DaDianNao的NFU结构如下所示:

-

-

-

-上图:DaDianNao: A Machine-Learning Supercomputer,figure 6

-

-### ShiDianNao

-

-ShiDianNao是机器视觉专用加速器,集成了视频处理的部分,它也是DianNao系列中唯一一个考虑运算单元级数据重用的加速器,也是唯一使用二维运算阵列的加速器,其加速器的运算阵列结构如下所示:

-

- -

-上图:ShiDianNao: Shifting vision processing closer to the sensor,figure 5

-

-ShiDianNao的运算阵列为2D格点结构,对于每一个运算单元(节点)而言,运算所使用的参数统一来源于Kernel,而参与运算的数据则可能来自于:数据缓存NBin,下方的节点,右侧的节点。

-

-下图为每个运算单元的结构:

-

-

-

-

-

-上图:ShiDianNao: Shifting vision processing closer to the sensor,figure 6

-

-该计算节点的功能包括转发数据和进行计算:

-

-转发数据:每个数据可来源于右侧节点,下方节点和NBin,根据控制信号选择其中一个存储到输入寄存器中,且根据控制信号可选的将其存储到FIFO-H和FIFO-V中。同时根据控制信号选择FIFO-H和FIFO-V中的信号从FIFO output端口输出

-

-进行计算:根据控制信号进行计算,包括相加,累加,乘加和比较等,并将结果存储到输出寄存器中,并根据控制信号选择寄存器或计算结果输出到PE output端口。

-

-对于计算功能,根据上文的结构图,可以发现,PE支持的运算有:kernel和输入数据相乘并与输出寄存器数据相加(乘加),输入数据与输出寄存器数据取最大或最小(应用于池化),kernel与输入数据相加(向量加法),输入数据与输出寄存器数据相加(累加)等。

-

-### PuDianNao

-

-作为DianNao系列的收山之作,PuDianNao的运算单元是电脑系列中唯一一个异构的,除了有MLU(机器学习单元)外,还有一个ALU用于处理通用运算和MLU无法处理的运算,其运算单元(上)和MLU(下)结构如下图所示:

-

-

-

-上图:PuDianNao: A Polyvalent Machine Learning Accelerator,figure 11&12

-

-该MLU共分为6层:

-

-计数层/比较层:这一层的处理为两个数按位与或比较大小,结果将被累加,这一层可以单独输出且可以被bypass

-

-加法层:这一层为两个输入对应相加,这一层可以单独输出且可以被bypass

-

-乘法层:这一层为两个输入或上一层(加法层)结果对应位置相乘,可以单独输出

-

-加法树层:将乘法层的结果累加

-

-累加层:将上一层(加法树层)的结果累加,可以单独输出

-

-特殊处理层:由一个分段线性逼近实现的非线性函数和k排序器(输出上一层输出中最小的输出)组成

-

-该运算单元是DianNao系列中功能最多的单元,配置非常灵活。例如实现向量相乘(对应位置相乘后累加)时,弃用计数层,加法层,将数据从乘法层,加法树层和累加层流过即可实现。

-

-PuDianNao支持7种机器学习算法:神经网络,线性模型,支持向量机,决策树,朴素贝叶斯,K临近和K类聚,所需要支持的运算较多,因此PuDianNao的运算分析主要集中在存储方面,其运算核心的设计中说明PuDianNao支持的运算主要有:向量点乘,距离计算,计数,排序和非线性函数。其他未覆盖的计算使用ALU实现。

-

-

-

-## 参考资料:

-

-[In-datacenter performance analysis of a tensor processing unit](https://ieeexplore.ieee.org/abstract/document/8192463)

-

-[Neural Network Processor](https://www.freepatentsonline.com/y2017/0103313.html)

-

-[DianNao: a small-footprint high-throughput accelerator for ubiquitous machine-learning](https://dl.acm.org/doi/abs/10.1145/2654822.2541967)

-

-[DaDianNao: A Machine-Learning Supercomputer](https://ieeexplore.ieee.org/document/7011421)

-

-[ShiDianNao: Shifting vision processing closer to the sensor](https://ieeexplore.ieee.org/document/7284058)

-

-[PuDianNao: A Polyvalent Machine Learning Accelerator](https://dl.acm.org/doi/abs/10.1145/2775054.2694358)

diff --git "a/docs/_sources/\347\254\254\344\272\214\347\253\240/2.4 \345\205\266\344\273\226\345\212\240\351\200\237\350\256\276\345\244\207.md.txt" "b/docs/_sources/\347\254\254\344\272\214\347\253\240/2.4 \345\205\266\344\273\226\345\212\240\351\200\237\350\256\276\345\244\207.md.txt"

deleted file mode 100644

index 02514c20b..000000000

--- "a/docs/_sources/\347\254\254\344\272\214\347\253\240/2.4 \345\205\266\344\273\226\345\212\240\351\200\237\350\256\276\345\244\207.md.txt"

+++ /dev/null

@@ -1,155 +0,0 @@

-# AI硬件加速设备

-

-在进行模型部署和训练时,我们有时会受限于CPU和GPU的性能。这时,专用的AI芯片就显得尤为重要。

-

-经过本节的学习,你将收获:

-

-- 什么是TPU

-- 什么是NPU

-

-## 2.4.1 TPU

-

-TPU即Tensor Processing Unit,中文名为张量处理器。2006年,谷歌开始计划为神经网络构建一个专用的集成电路(ASIC)。随着计算需求和数据量的不断上涨,这个需求在2013年开始变得尤为紧迫。于是,谷歌在2015年6月的IO开发者大会上推出了为优化自身的TensorFlow框架而设计打造的一款计算神经网络专用芯片。它主要用于进行搜索,图像,语音等模型和技术的处理。

-

-截至目前,谷歌已经发行了四代TPU芯片。

-

-### 芯片架构设计

-

-TPU的设计架构如下图

-

-

-

-上图:ShiDianNao: Shifting vision processing closer to the sensor,figure 5

-

-ShiDianNao的运算阵列为2D格点结构,对于每一个运算单元(节点)而言,运算所使用的参数统一来源于Kernel,而参与运算的数据则可能来自于:数据缓存NBin,下方的节点,右侧的节点。

-

-下图为每个运算单元的结构:

-

-

-

-

-

-上图:ShiDianNao: Shifting vision processing closer to the sensor,figure 6

-

-该计算节点的功能包括转发数据和进行计算:

-

-转发数据:每个数据可来源于右侧节点,下方节点和NBin,根据控制信号选择其中一个存储到输入寄存器中,且根据控制信号可选的将其存储到FIFO-H和FIFO-V中。同时根据控制信号选择FIFO-H和FIFO-V中的信号从FIFO output端口输出

-

-进行计算:根据控制信号进行计算,包括相加,累加,乘加和比较等,并将结果存储到输出寄存器中,并根据控制信号选择寄存器或计算结果输出到PE output端口。

-

-对于计算功能,根据上文的结构图,可以发现,PE支持的运算有:kernel和输入数据相乘并与输出寄存器数据相加(乘加),输入数据与输出寄存器数据取最大或最小(应用于池化),kernel与输入数据相加(向量加法),输入数据与输出寄存器数据相加(累加)等。

-

-### PuDianNao

-

-作为DianNao系列的收山之作,PuDianNao的运算单元是电脑系列中唯一一个异构的,除了有MLU(机器学习单元)外,还有一个ALU用于处理通用运算和MLU无法处理的运算,其运算单元(上)和MLU(下)结构如下图所示:

-

-

-

-上图:PuDianNao: A Polyvalent Machine Learning Accelerator,figure 11&12

-

-该MLU共分为6层:

-

-计数层/比较层:这一层的处理为两个数按位与或比较大小,结果将被累加,这一层可以单独输出且可以被bypass

-

-加法层:这一层为两个输入对应相加,这一层可以单独输出且可以被bypass

-

-乘法层:这一层为两个输入或上一层(加法层)结果对应位置相乘,可以单独输出

-

-加法树层:将乘法层的结果累加

-

-累加层:将上一层(加法树层)的结果累加,可以单独输出

-

-特殊处理层:由一个分段线性逼近实现的非线性函数和k排序器(输出上一层输出中最小的输出)组成

-

-该运算单元是DianNao系列中功能最多的单元,配置非常灵活。例如实现向量相乘(对应位置相乘后累加)时,弃用计数层,加法层,将数据从乘法层,加法树层和累加层流过即可实现。

-

-PuDianNao支持7种机器学习算法:神经网络,线性模型,支持向量机,决策树,朴素贝叶斯,K临近和K类聚,所需要支持的运算较多,因此PuDianNao的运算分析主要集中在存储方面,其运算核心的设计中说明PuDianNao支持的运算主要有:向量点乘,距离计算,计数,排序和非线性函数。其他未覆盖的计算使用ALU实现。

-

-

-

-## 参考资料:

-

-[In-datacenter performance analysis of a tensor processing unit](https://ieeexplore.ieee.org/abstract/document/8192463)

-

-[Neural Network Processor](https://www.freepatentsonline.com/y2017/0103313.html)

-

-[DianNao: a small-footprint high-throughput accelerator for ubiquitous machine-learning](https://dl.acm.org/doi/abs/10.1145/2654822.2541967)

-

-[DaDianNao: A Machine-Learning Supercomputer](https://ieeexplore.ieee.org/document/7011421)

-

-[ShiDianNao: Shifting vision processing closer to the sensor](https://ieeexplore.ieee.org/document/7284058)

-

-[PuDianNao: A Polyvalent Machine Learning Accelerator](https://dl.acm.org/doi/abs/10.1145/2775054.2694358)

diff --git "a/docs/_sources/\347\254\254\344\272\214\347\253\240/2.4 \345\205\266\344\273\226\345\212\240\351\200\237\350\256\276\345\244\207.md.txt" "b/docs/_sources/\347\254\254\344\272\214\347\253\240/2.4 \345\205\266\344\273\226\345\212\240\351\200\237\350\256\276\345\244\207.md.txt"

deleted file mode 100644

index 02514c20b..000000000

--- "a/docs/_sources/\347\254\254\344\272\214\347\253\240/2.4 \345\205\266\344\273\226\345\212\240\351\200\237\350\256\276\345\244\207.md.txt"

+++ /dev/null

@@ -1,155 +0,0 @@

-# AI硬件加速设备

-

-在进行模型部署和训练时,我们有时会受限于CPU和GPU的性能。这时,专用的AI芯片就显得尤为重要。

-

-经过本节的学习,你将收获:

-

-- 什么是TPU

-- 什么是NPU

-

-## 2.4.1 TPU

-

-TPU即Tensor Processing Unit,中文名为张量处理器。2006年,谷歌开始计划为神经网络构建一个专用的集成电路(ASIC)。随着计算需求和数据量的不断上涨,这个需求在2013年开始变得尤为紧迫。于是,谷歌在2015年6月的IO开发者大会上推出了为优化自身的TensorFlow框架而设计打造的一款计算神经网络专用芯片。它主要用于进行搜索,图像,语音等模型和技术的处理。

-

-截至目前,谷歌已经发行了四代TPU芯片。

-

-### 芯片架构设计

-

-TPU的设计架构如下图

-

- -

-由上图可见,整个TPU中最重要的计算单元是右上角黄色的矩阵乘单元“Matrix Multiply Unit”,它包含256x256个MAC部件,每一个能够执行有符号或者无符号的8位乘加操作。它的输入为权重数据队列FIFO和统一缓冲Unified Buffer,即图中指向它的两个蓝色部分。在计算结束后,16位结果被收集并传递到位于矩阵单元下方的4MiB 32位蓝色累加器Accumulators中,之后由黄色的激活单元在累加后执行非线性函数,并最终将数据返回给统一缓冲。

-

-Matrix Multiply Unit矩阵处理器作为TPU的核心部分,它可以在单个时钟周期内处理数十万次矩阵(Matrix)运算。MMU有着与传统CPU、GPU截然不同的架构,称为脉动阵列(systolic array)。之所以叫“脉动”,是因为在这种结构中,数据一波一波地流过芯片,与心脏跳动供血的方式类似。而如下图所示,CPU和GPU在每次运算中都需要从多个寄存器(register)中进行存取,而TPU的脉动阵列将多个运算逻辑单元(ALU)串联在一起,复用从一个寄存器中读取的结果。每个ALU单元结构简单,一般只包含乘法器、加法器以及寄存器三部分,适合大量堆砌。

-

-

-

-但是,在极大增加数据复用、降低内存带宽压力的同时,脉动阵列也有两个缺点,即数据重排和规模适配。第一,脉动矩阵主要实现向量/矩阵乘法。以CNN计算为例,CNN数据进入脉动阵列需要调整好形式,并且严格遵循时钟节拍和空间顺序输入。数据重排的额外操作增加了复杂性。第二,在数据流经整个阵列后,才能输出结果。当计算的向量中元素过少,脉动阵列规模过大时,不仅难以将阵列中的每个单元都利用起来,数据的导入和导出延时也随着尺寸扩大而增加,降低了计算效率。因此在确定脉动阵列的规模时,在考虑面积、能耗、峰值计算能力的同时,还要考虑典型应用下的效率。

-

-### 技术特点

-

-#### AI加速专用

-

-TPU的架构属于Domain-specific Architecture,定位准确,架构简单,单线程控制,定制指令集,架构在深度学习运算方面效率极高,且容易扩展。相比之下,传统诸如CPU、GPU等通用处理器必须考虑灵活性和兼容性,有太重的包袱。但TPU这种特点也决定它只能被限制用于深度学习加速场景。

-

-#### 脉动阵列设计

-

-TPU采用了与传统CPU和GPU截然不同的脉动阵列(systolic array)结构来加速AI运算,脉动阵列能够在一个时钟周期内处理数十万次矩阵运算,在每次运算过程中,TPU能够将多个运算逻辑单元(ALU)串联在一起,并复用从一个寄存器中取得的结果。这种设计,不仅能够将数据复用实现最大化,减少芯片在运算过程中的内存访问次数,提高AI计算效率,同时也降低了内存带宽压力,进而降低内存访问的能耗。

-

-MMU的脉动阵列包含256 × 256 = 65,536个ALU,也就是说TPU每个周期可以处理65,536次8位整数的乘法和加法。

-

-TPU以700兆赫兹的功率运行,也就是说,它每秒可以运行65,536 × 700,000,000 = 46 × 1012次乘法和加法运算,或每秒92万亿(92 × 1012)次矩阵单元中的运算。

-

-

-

-#### 确定性功能和大规模片上内存

-

-如图是TPU的平面设计简图,黄色为MMU运算单元,蓝色是统一缓存和累加器等数据单元,绿色是I/O,红色是逻辑控制单元。

-

-

-

-由上图可见,整个TPU中最重要的计算单元是右上角黄色的矩阵乘单元“Matrix Multiply Unit”,它包含256x256个MAC部件,每一个能够执行有符号或者无符号的8位乘加操作。它的输入为权重数据队列FIFO和统一缓冲Unified Buffer,即图中指向它的两个蓝色部分。在计算结束后,16位结果被收集并传递到位于矩阵单元下方的4MiB 32位蓝色累加器Accumulators中,之后由黄色的激活单元在累加后执行非线性函数,并最终将数据返回给统一缓冲。

-

-Matrix Multiply Unit矩阵处理器作为TPU的核心部分,它可以在单个时钟周期内处理数十万次矩阵(Matrix)运算。MMU有着与传统CPU、GPU截然不同的架构,称为脉动阵列(systolic array)。之所以叫“脉动”,是因为在这种结构中,数据一波一波地流过芯片,与心脏跳动供血的方式类似。而如下图所示,CPU和GPU在每次运算中都需要从多个寄存器(register)中进行存取,而TPU的脉动阵列将多个运算逻辑单元(ALU)串联在一起,复用从一个寄存器中读取的结果。每个ALU单元结构简单,一般只包含乘法器、加法器以及寄存器三部分,适合大量堆砌。

-

-

-

-但是,在极大增加数据复用、降低内存带宽压力的同时,脉动阵列也有两个缺点,即数据重排和规模适配。第一,脉动矩阵主要实现向量/矩阵乘法。以CNN计算为例,CNN数据进入脉动阵列需要调整好形式,并且严格遵循时钟节拍和空间顺序输入。数据重排的额外操作增加了复杂性。第二,在数据流经整个阵列后,才能输出结果。当计算的向量中元素过少,脉动阵列规模过大时,不仅难以将阵列中的每个单元都利用起来,数据的导入和导出延时也随着尺寸扩大而增加,降低了计算效率。因此在确定脉动阵列的规模时,在考虑面积、能耗、峰值计算能力的同时,还要考虑典型应用下的效率。

-

-### 技术特点

-

-#### AI加速专用

-

-TPU的架构属于Domain-specific Architecture,定位准确,架构简单,单线程控制,定制指令集,架构在深度学习运算方面效率极高,且容易扩展。相比之下,传统诸如CPU、GPU等通用处理器必须考虑灵活性和兼容性,有太重的包袱。但TPU这种特点也决定它只能被限制用于深度学习加速场景。

-

-#### 脉动阵列设计

-

-TPU采用了与传统CPU和GPU截然不同的脉动阵列(systolic array)结构来加速AI运算,脉动阵列能够在一个时钟周期内处理数十万次矩阵运算,在每次运算过程中,TPU能够将多个运算逻辑单元(ALU)串联在一起,并复用从一个寄存器中取得的结果。这种设计,不仅能够将数据复用实现最大化,减少芯片在运算过程中的内存访问次数,提高AI计算效率,同时也降低了内存带宽压力,进而降低内存访问的能耗。

-

-MMU的脉动阵列包含256 × 256 = 65,536个ALU,也就是说TPU每个周期可以处理65,536次8位整数的乘法和加法。

-

-TPU以700兆赫兹的功率运行,也就是说,它每秒可以运行65,536 × 700,000,000 = 46 × 1012次乘法和加法运算,或每秒92万亿(92 × 1012)次矩阵单元中的运算。

-

-

-

-#### 确定性功能和大规模片上内存

-

-如图是TPU的平面设计简图,黄色为MMU运算单元,蓝色是统一缓存和累加器等数据单元,绿色是I/O,红色是逻辑控制单元。

-

- -

-传统GPU由于片上内存较少,因此在运行过程中需要不断地去访问片外动态随机存取存储器(DRAM),从而在一定程度上浪费了不必要的能耗。与CPU和GPU相比,TPU的控制单元更小,更容易设计,面积只占了整个冲模的2%,给片上存储器和运算单元留下了更大的空间。如上图所示的TPU一代架构中,总共设计了占总芯片面积35%的内存,其中包括24MB的局部内存、4MB的累加器内存,以及用于与主控处理器对接的内存。这一比例大大超出了GPU等通用处理器,节约了大量片外数据访存能耗,使得TPU计算的能效比大大提高。从TPU二代开始采用HBM片上高带宽内存,虽然和最新一代GPU片上内存技术相同,但是TPU芯片的面积要远远小于GPU。硅片越小,成本越低,良品率也越高。

-

-另外,由于TPU是一个单用途芯片,不需要考虑缓存、分支预测、多道处理等问题。这就意味着TPU的功能是单一且确定的。因此,我们可以使用TPU轻易的预测运行一个神经网络需要多长时间,这样我们就能让芯片以吞吐量接近峰值的状态运行,同时严格控制延迟。

-

-## 2.4.2 NPU

-

-NPU即Neural-network Processing Unit,中文名为神经网络处理器,它采用“数据驱动并行计算”的架构,特别擅长处理视频、图像类的海量多媒体数据。

-

-长期以来,应用需求一直牵动着嵌入式技术的发展方向。随着深度学习神经网络的兴起,人工智能、大数据时代的来临,CPU和GPU渐渐难以满足深度学习的需要,面对日渐旺盛的需求和广大的预期市场,设计一款专门用于神经网络深度学习的高效智能处理器显得十分必要,因此NPU应运而生。

-从技术角度看,深度学习实际上是一类多层大规模人工神经网络。它模仿生物神经网络而构建,由若干人工神经元结点互联而成。神经元之间通过突触两两连接,突触记录了神经元间联系的权值强弱。由于深度学习的基本操作是神经元和突触的处理,神经网络中存储和处理是一体化的,都是通过突触权重来体现,而冯·诺伊曼结构中,存储和处理是分离的,分别由存储器和运算器来实现,二者之间存在巨大的差异。当用现有的基于冯·诺伊曼结构的经典计算机(如X86处理器和英伟达GPU)运行神经网络应用时,就不可避免地受到存储和处理分离式结构的制约,因而影响效率。因此,专门针对人工智能的专业芯片NPU更有研发的必要和需求。

-

-在NPU的设计上,中国走在了世界前列。下面我们将以寒武纪的DianNao系列架构为例,来简要介绍NPU。

-

-### DianNao

-

-

-

-

-

-基于神经网络的人工智能算法,是模拟人类大脑内部神经元的结构。上图中的neuron代表的就是单个神经元,synapse代表神经元的突触。这个模型的工作模式,就要结合高中生物课的知识了。

-

-一个神经元,有许多突触,给别的神经元传递信息。同样,这个神经元,也会接收来自许多其他神经元的信息。这个神经元所有接受到的信息累加,会有一个强烈程度,在生物上是以化学成分的形式存在,当这些信息达到一定的强烈程度,就会使整个神经元处于兴奋状态(激活),否则就是不兴奋(不激活)。如果兴奋了,就给其他神经元传递信息,如果不兴奋,就不传递。这就是单独一个神经元的工作模式。那么有成千上万个这样的神经元组合起来,就是一个神经网络模型。

-

-那么DianNao是如何模拟神经元进行工作的呢,我们可以看看它的内部结构图:

-

-

-

-如图所示,上图中浅蓝色的部分就是用硬件逻辑模拟的神经网络架构,称为NFU(Neural Functional Units)。它可以被细分为三个部分,即途中的NFU-1,NFU-2,和NFU-3。

-

-NFU-1是乘法单元,它采用16bit定点数乘法器,1位符号位,5位整数位,10位小数位。该部分总计有256个乘法器。这些乘法器的计算是同时的,也就是说,在一个周期内可以执行256次乘法。

-

-NFU-2是加法树,总计16个,每一个加法树都是8-4-2-1这样的组成结构,即就是每一个加法树中都有15个加法器。

-

-NFU-3是非线性激活函数,该部分由分段线性近似实现非线性函数,根据前面两个单元计算得到的刺激量,从而判断是否需要激活操作。

-

-当需要实现向量相乘和卷积运算时,使用NFU-1完成对应位置元素相乘,NFU-2完成相乘结果相加,最后由NFU-3完成激活函数映射。完成池化运算时,使用NFU-2完成多个元素取最大值或取平均值运算。由此分析,尽管该运算模块非常简单,也覆盖了神经网络所需要的大部分运算。

-

-### DaDianNao

-

-作为DianNao的多核升级版本,DaDianNao的运算单元NFU与DianNao基本相同,最大的区别是为了完成训练任务多加了几条数据通路,且配置更加灵活。NFU的尺寸为16x16,即16个输出神经元,每个输出神经元有16个输入(输入端需要一次提供256个数据)。同时,NFU可以可选的跳过一些步骤以达到灵活可配置的功能。DaDianNao的NFU结构如下所示:

-

-

-

-### ShiDianNao

-

-ShiDianNao是机器视觉专用加速器,集成了视频处理的部分,它也是DianNao系列中唯一一个考虑运算单元级数据重用的加速器,也是唯一使用二维运算阵列的加速器,其加速器的运算阵列结构如下所示:

-

-

-

-ShiDianNao的运算阵列为2D格点结构,对于每一个运算单元(节点)而言,运算所使用的参数统一来源于Kernel,而参与运算的数据则可能来自于:数据缓存NBin,下方的节点,右侧的节点。

-

-下图为每个运算单元的结构:

-

-

-

-

-

-该计算节点的功能包括转发数据和进行计算:

-

-转发数据:每个数据可来源于右侧节点,下方节点和NBin,根据控制信号选择其中一个存储到输入寄存器中,且根据控制信号可选的将其存储到FIFO-H和FIFO-V中。同时根据控制信号选择FIFO-H和FIFO-V中的信号从FIFO output端口输出

-

-进行计算:根据控制信号进行计算,包括相加,累加,乘加和比较等,并将结果存储到输出寄存器中,并根据控制信号选择寄存器或计算结果输出到PE output端口。

-

-对于计算功能,根据上文的结构图,可以发现,PE支持的运算有:kernel和输入数据相乘并与输出寄存器数据相加(乘加),输入数据与输出寄存器数据取最大或最小(应用于池化),kernel与输入数据相加(向量加法),输入数据与输出寄存器数据相加(累加)等。

-

-### DuDianNao

-

-作为DianNao系列的收山之作,PuDianNao的运算单元是电脑系列中唯一一个异构的,除了有MLU(机器学习单元)外,还有一个ALU用于处理通用运算和MLU无法处理的运算,其运算单元(左)和MLU(右)结构如下图所示:

-

-

-

-MLU共分为6层:

-

-计数层/比较层:这一层的处理为两个数按位与或比较大小,结果将被累加,这一层可以单独输出且可以被bypass

-

-加法层:这一层为两个输入对应相加,这一层可以单独输出且可以被bypass

-

-乘法层:这一层为两个输入或上一层(加法层)结果对应位置相乘,可以单独输出

-

-加法树层:将乘法层的结果累加

-

-累加层:将上一层(加法树层)的结果累加,可以单独输出

-

-特殊处理层:由一个分段线性逼近实现的非线性函数和k排序器(输出上一层输出中最小的输出)组成

-

-该运算单元是DianNao系列中功能最多的单元,配置非常灵活。例如实现向量相乘(对应位置相乘后累加)时,弃用计数层,加法层,将数据从乘法层,加法树层和累加层流过即可实现。

-

-PuDianNao支持7种机器学习算法:神经网络,线性模型,支持向量机,决策树,朴素贝叶斯,K临近和K类聚,所需要支持的运算较多,因此PuDianNao的运算分析主要集中在存储方面,其运算核心的设计中说明PuDianNao支持的运算主要有:向量点乘,距离计算,计数,排序和非线性函数。其他未覆盖的计算使用ALU实现。

-

-

-

-## 参考资料:

-

-[In-datacenter performance analysis of a tensor processing unit](https://ieeexplore.ieee.org/abstract/document/8192463)

-

-[Neural Network Processor](https://www.freepatentsonline.com/y2017/0103313.html)

-

-[DianNao: a small-footprint high-throughput accelerator for ubiquitous machine-learning](https://dl.acm.org/doi/abs/10.1145/2654822.2541967)

-

-[DaDianNao: A Machine-Learning Supercomputer](https://ieeexplore.ieee.org/document/7011421)

-

-[ShiDianNao: Shifting vision processing closer to the sensor](https://ieeexplore.ieee.org/document/7284058)

-

-[PuDianNao: A Polyvalent Machine Learning Accelerator](https://dl.acm.org/doi/abs/10.1145/2775054.2694358)

diff --git "a/docs/_sources/\347\254\254\344\272\214\347\253\240/index.md.txt" "b/docs/_sources/\347\254\254\344\272\214\347\253\240/index.md.txt"

deleted file mode 100644

index 0976d0804..000000000

--- "a/docs/_sources/\347\254\254\344\272\214\347\253\240/index.md.txt"

+++ /dev/null

@@ -1,8 +0,0 @@

-# 第二章:PyTorch基础知识

-```{toctree}

-:maxdepth: 2

-2.1 张量

-2.2 自动求导

-2.3 并行计算简介

-2.4 AI硬件加速设备

-```

\ No newline at end of file

diff --git "a/docs/_sources/\347\254\254\344\272\224\347\253\240/5.1 PyTorch\346\250\241\345\236\213\345\256\232\344\271\211\347\232\204\346\226\271\345\274\217.md.txt" "b/docs/_sources/\347\254\254\344\272\224\347\253\240/5.1 PyTorch\346\250\241\345\236\213\345\256\232\344\271\211\347\232\204\346\226\271\345\274\217.md.txt"

deleted file mode 100644

index e96da231b..000000000

--- "a/docs/_sources/\347\254\254\344\272\224\347\253\240/5.1 PyTorch\346\250\241\345\236\213\345\256\232\344\271\211\347\232\204\346\226\271\345\274\217.md.txt"

+++ /dev/null

@@ -1,181 +0,0 @@

-# 5.1 PyTorch模型定义的方式

-

-模型在深度学习中扮演着重要的角色,好的模型极大地促进了深度学习的发展进步,比如CNN的提出解决了图像、视频处理中的诸多问题,RNN/LSTM模型解决了序列数据处理的问题,GNN在图模型上发挥着重要的作用。当我们在向他人介绍一项深度学习工作的时候,对方可能首先要问的就是使用了哪些模型。因此,在PyTorch进阶操作的第一部分中,我们首先来学习PyTorch模型相关的内容。

-

-在第一部分课程的第三章中,我们已经学习了模型中的“层“是如何定义的,以及基础的模型是如何构建的。这里我们来更为系统地学习PyTorch中模型定义的方式,本节的学习将为后续灵活构建自己的模型打下坚实的基础。

-

-经过本节的学习,你将收获*:

-

-- 熟悉PyTorch中模型定义的三种方式

-- 读懂GitHub上千奇百怪的写法

-- 自己根据需要灵活选取模型定义方式

-

-[^*]: 进阶部分内容剑指实战,通过”你将收获“部分帮助大家有针对性地学习

-

-

-

-## 5.1.1 必要的知识回顾

-

-- `Module` 类是 `torch.nn` 模块里提供的一个模型构造类 (`nn.Module`),是所有神经⽹网络模块的基类,我们可以继承它来定义我们想要的模型;

-- PyTorch模型定义应包括两个主要部分:各个部分的初始化(`__init__`);数据流向定义(`forward`)

-

-基于`nn.Module`,我们可以通过`Sequential`,`ModuleList`和`ModuleDict`三种方式定义PyTorch模型。

-

-下面我们就来逐个探索这三种模型定义方式。

-

-

-

-## 5.1.2 Sequential

-

-对应模块为`nn.Sequential()`。

-

-当模型的前向计算为简单串联各个层的计算时, `Sequential` 类可以通过更加简单的方式定义模型。它可以接收一个子模块的有序字典(OrderedDict) 或者一系列子模块作为参数来逐一添加 `Module` 的实例,⽽模型的前向计算就是将这些实例按添加的顺序逐⼀计算。我们结合`Sequential`和定义方式加以理解:

-

-```python

-from collections import OrderedDict

-class MySequential(nn.Module):

- def __init__(self, *args):

- super(MySequential, self).__init__()

- if len(args) == 1 and isinstance(args[0], OrderedDict): # 如果传入的是一个OrderedDict

- for key, module in args[0].items():

- self.add_module(key, module)

- # add_module方法会将module添加进self._modules(一个OrderedDict)

- else: # 传入的是一些Module

- for idx, module in enumerate(args):

- self.add_module(str(idx), module)

- def forward(self, input):

- # self._modules返回一个 OrderedDict,保证会按照成员添加时的顺序遍历成

- for module in self._modules.values():

- input = module(input)

- return input

-```

-

-下面来看下如何使用`Sequential`来定义模型。只需要将模型的层按序排列起来即可,根据层名的不同,排列的时候有两种方式:

-

-- 直接排列

-

-```python

-import torch.nn as nn

-net = nn.Sequential(

- nn.Linear(784, 256),

- nn.ReLU(),

- nn.Linear(256, 10),

- )

-print(net)

-```

-

-```

-Sequential(

- (0): Linear(in_features=784, out_features=256, bias=True)

- (1): ReLU()

- (2): Linear(in_features=256, out_features=10, bias=True)

-)

-```

-

-- 使用OrderedDict:

-

-```python

-import collections

-import torch.nn as nn

-net2 = nn.Sequential(collections.OrderedDict([

- ('fc1', nn.Linear(784, 256)),

- ('relu1', nn.ReLU()),

- ('fc2', nn.Linear(256, 10))

- ]))

-print(net2)

-```

-

-```

-Sequential(

- (fc1): Linear(in_features=784, out_features=256, bias=True)

- (relu1): ReLU()

- (fc2): Linear(in_features=256, out_features=10, bias=True)

-)

-```

-

-可以看到,使用`Sequential`定义模型的好处在于简单、易读,同时使用`Sequential`定义的模型不需要再写`forward`,因为顺序已经定义好了。但使用`Sequential`也会使得模型定义丧失灵活性,比如需要在模型中间加入一个外部输入时就不适合用`Sequential`的方式实现。使用时需根据实际需求加以选择。

-

-

-

-## 5.1.3 ModuleList

-

-对应模块为`nn.ModuleList()`。

-

-`ModuleList` 接收一个子模块(或层,需属于`nn.Module`类)的列表作为输入,然后也可以类似`List`那样进行append和extend操作。同时,子模块或层的权重也会自动添加到网络中来。

-

-```python

-net = nn.ModuleList([nn.Linear(784, 256), nn.ReLU()])

-net.append(nn.Linear(256, 10)) # # 类似List的append操作

-print(net[-1]) # 类似List的索引访问

-print(net)

-```

-

-```

-Linear(in_features=256, out_features=10, bias=True)

-ModuleList(

- (0): Linear(in_features=784, out_features=256, bias=True)

- (1): ReLU()

- (2): Linear(in_features=256, out_features=10, bias=True)

-)

-```

-

-要特别注意的是,`nn.ModuleList` 并没有定义一个网络,它只是将不同的模块储存在一起。`ModuleList`中元素的先后顺序并不代表其在网络中的真实位置顺序,需要经过forward函数指定各个层的先后顺序后才算完成了模型的定义。具体实现时用for循环即可完成:

-

-```python

-class model(nn.Module):

- def __init__(self, ...):

- super().__init__()

- self.modulelist = ...

- ...

-

- def forward(self, x):

- for layer in self.modulelist:

- x = layer(x)

- return x

-```

-

-

-

-## 5.1.4 ModuleDict

-

-对应模块为`nn.ModuleDict()`。

-

-`ModuleDict`和`ModuleList`的作用类似,只是`ModuleDict`能够更方便地为神经网络的层添加名称。

-

-```python

-net = nn.ModuleDict({

- 'linear': nn.Linear(784, 256),

- 'act': nn.ReLU(),

-})

-net['output'] = nn.Linear(256, 10) # 添加

-print(net['linear']) # 访问

-print(net.output)

-print(net)

-```

-

-```

-Linear(in_features=784, out_features=256, bias=True)

-Linear(in_features=256, out_features=10, bias=True)

-ModuleDict(

- (act): ReLU()

- (linear): Linear(in_features=784, out_features=256, bias=True)

- (output): Linear(in_features=256, out_features=10, bias=True)

-)

-```

-

-

-

-## 5.1.5 三种方法的比较与适用场景

-

-`Sequential`适用于快速验证结果,因为已经明确了要用哪些层,直接写一下就好了,不需要同时写`__init__`和`forward`;

-

-ModuleList和ModuleDict在某个完全相同的层需要重复出现多次时,非常方便实现,可以”一行顶多行“;

-

-当我们需要之前层的信息的时候,比如 ResNets 中的残差计算,当前层的结果需要和之前层中的结果进行融合,一般使用 ModuleList/ModuleDict 比较方便。

-

-

-

-## 本节参考

-

-【1】https://zhuanlan.zhihu.com/p/64990232

-

diff --git "a/docs/_sources/\347\254\254\344\272\224\347\253\240/5.2 \345\210\251\347\224\250\346\250\241\345\236\213\345\235\227\345\277\253\351\200\237\346\220\255\345\273\272\345\244\215\346\235\202\347\275\221\347\273\234.md.txt" "b/docs/_sources/\347\254\254\344\272\224\347\253\240/5.2 \345\210\251\347\224\250\346\250\241\345\236\213\345\235\227\345\277\253\351\200\237\346\220\255\345\273\272\345\244\215\346\235\202\347\275\221\347\273\234.md.txt"

deleted file mode 100644

index 91f7daffc..000000000

--- "a/docs/_sources/\347\254\254\344\272\224\347\253\240/5.2 \345\210\251\347\224\250\346\250\241\345\236\213\345\235\227\345\277\253\351\200\237\346\220\255\345\273\272\345\244\215\346\235\202\347\275\221\347\273\234.md.txt"

+++ /dev/null

@@ -1,179 +0,0 @@

-# 5.2 利用模型块快速搭建复杂网络

-

-上一节中我们介绍了怎样定义PyTorch的模型,其中给出的示例都是用`torch.nn`中的层来完成的。这种定义方式易于理解,在实际场景下不一定利于使用。当模型的深度非常大时候,使用`Sequential`定义模型结构需要向其中添加几百行代码,使用起来不甚方便。

-

-对于大部分模型结构(比如ResNet、DenseNet等),我们仔细观察就会发现,虽然模型有很多层, 但是其中有很多重复出现的结构。考虑到每一层有其输入和输出,若干层串联成的”模块“也有其输入和输出,如果我们能将这些重复出现的层定义为一个”模块“,每次只需要向网络中添加对应的模块来构建模型,这样将会极大便利模型构建的过程。

-

-本节我们将以U-Net为例,介绍如何构建模型块,以及如何利用模型块快速搭建复杂模型。

-

-经过本节的学习,你将收获:

-

-- 利用上一节学到的知识,将简单层构建成具有特定功能的模型块

-- 利用模型块构建复杂网络

-

-

-

-## 5.2.1 U-Net简介

-

-U-Net是分割 (Segmentation) 模型的杰作,在以医学影像为代表的诸多领域有着广泛的应用。U-Net模型结构如下图所示,通过残差连接结构解决了模型学习中的退化问题,使得神经网络的深度能够不断扩展。

-

-

-

-

-

-## 5.2.2 U-Net模型块分析

-

-结合上图,不难发现U-Net模型具有非常好的对称性。模型从上到下分为若干层,每层由左侧和右侧两个模型块组成,每侧的模型块与其上下模型块之间有连接;同时位于同一层左右两侧的模型块之间也有连接,称为“Skip-connection”。此外还有输入和输出处理等其他组成部分。由于模型的形状非常像英文字母的“U”,因此被命名为“U-Net”。

-

-组成U-Net的模型块主要有如下几个部分:

-

-- 每个子块内部的两次卷积(Double Convolution)

-

-- 左侧模型块之间的下采样连接,即最大池化(Max pooling)

-

-- 右侧模型块之间的上采样连接(Up sampling)

-

-- 输出层的处理

-

-除模型块外,还有模型块之间的横向连接,输入和U-Net底部的连接等计算,这些单独的操作可以通过forward函数来实现。

-

-下面我们用PyTorch先实现上述的模型块,然后再利用定义好的模型块构建U-Net模型。

-

-

-

-## 5.2.3 U-Net模型块实现

-

-在使用PyTorch实现U-Net模型时,我们不必把每一层按序排列显式写出,这样太麻烦且不宜读,一种比较好的方法是先定义好模型块,再定义模型块之间的连接顺序和计算方式。就好比装配零件一样,我们先装配好一些基础的部件,之后再用这些可以复用的部件得到整个装配体。

-

-这里的基础部件对应上一节分析的四个模型块,根据功能我们将其命名为:`DoubleConv`, `Down`, `Up`, `OutConv`。下面给出U-Net中模型块的PyTorch 实现:

-

-```python

-import torch

-import torch.nn as nn

-import torch.nn.functional as F

-```

-

-```python

-class DoubleConv(nn.Module):

- """(convolution => [BN] => ReLU) * 2"""

-

- def __init__(self, in_channels, out_channels, mid_channels=None):

- super().__init__()

- if not mid_channels:

- mid_channels = out_channels

- self.double_conv = nn.Sequential(

- nn.Conv2d(in_channels, mid_channels, kernel_size=3, padding=1, bias=False),

- nn.BatchNorm2d(mid_channels),

- nn.ReLU(inplace=True),

- nn.Conv2d(mid_channels, out_channels, kernel_size=3, padding=1, bias=False),

- nn.BatchNorm2d(out_channels),

- nn.ReLU(inplace=True)

- )

-

- def forward(self, x):

- return self.double_conv(x)

-

-```

-

-```python

-class Down(nn.Module):

- """Downscaling with maxpool then double conv"""

-

- def __init__(self, in_channels, out_channels):

- super().__init__()

- self.maxpool_conv = nn.Sequential(

- nn.MaxPool2d(2),

- DoubleConv(in_channels, out_channels)

- )

-

- def forward(self, x):

- return self.maxpool_conv(x)

-

-```

-

-```python

-class Up(nn.Module):

- """Upscaling then double conv"""

-

- def __init__(self, in_channels, out_channels, bilinear=False):

- super().__init__()

-

- # if bilinear, use the normal convolutions to reduce the number of channels

- if bilinear:

- self.up = nn.Upsample(scale_factor=2, mode='bilinear', align_corners=True)

- self.conv = DoubleConv(in_channels, out_channels, in_channels // 2)

- else:

- self.up = nn.ConvTranspose2d(in_channels, in_channels // 2, kernel_size=2, stride=2)